Этика ИИ: как избежать ошибок в чат-ботах

Но возникает другой вопрос: готовы ли мы морально и профессионально к тем проблемам, которые приходят вместе с этой технологией?

В декабре 2024 года MIT опубликовал исследование. Результаты неприятные: чат-боты реагировали менее сочувственно на обращения чернокожих и азиатских пользователей, чем на запросы белых. Разрыв составлял от пары процентов до заметных десятков

Почему этика важна в чат-ботах

Современные ИИ-ассистенты обучаются на больших массивах данных и продолжают учиться в режиме реального времени. Но алгоритмы уязвимы к ошибкам, скрытым предубеждениям (bias) и «галлюцинациям», которые могут проявиться в процессе диалога. Последствия — от искажения информации до генерации токсичных или дискриминационных ответов

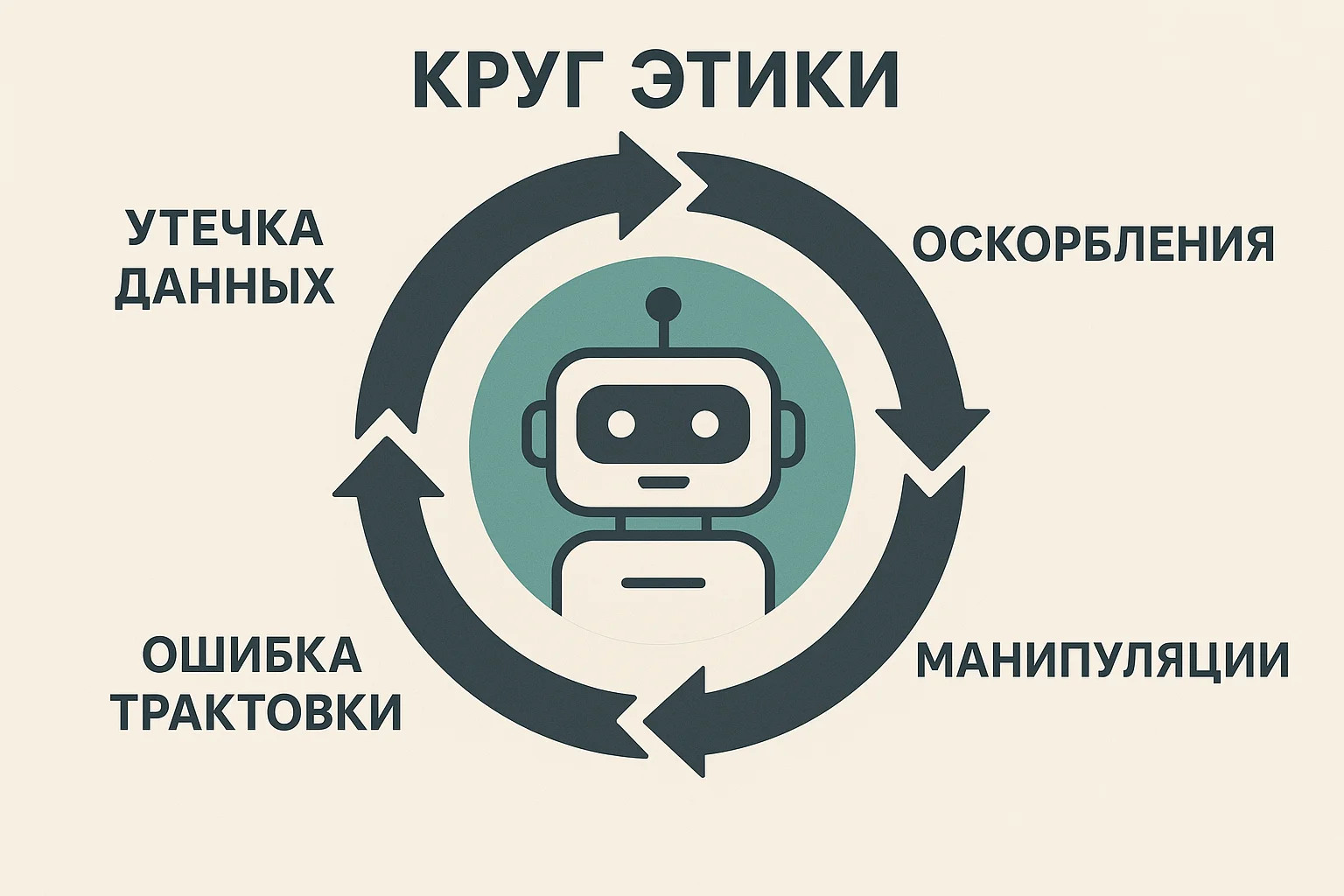

Основные этические проблемы современных чат-ботов

Галлюцинации и дезинформация

Одна из самых серьезных проблем — способность ИИ генерировать правдоподобную, но ложную информацию

Так, в марте 2024 года чат-бот NYC MyCity ввёл жителей Нью-Йорка в заблуждение: он уверял, что владельцы недвижимости якобы могут не принимать жилищные ваучеры Section 8. На деле это шло вразрез с местным законом, где как раз закреплена обратная норма

Скрытые предубеждения и проявления дискриминации

В одном исследовании, опубликованном в 2024 году, обнаружилась серьёзная проблема: алгоритмы для подбора персонала заметно чаще отклоняли резюме женщин — примерно на 40%. А системы распознавания лиц показывали особенно слабые результаты при идентификации людей с более тёмным цветом кожи

Последствия таких ошибок могут быть ощутимыми. Например, водитель Uber Eats потерял работу именно из-за сбоя в системе распознавания, которая неверно «не узнала» его лицо

Психологический вред пользователям

Чат-боты, особенно те, что пытаются подражать эмоциям, иногда создают у людей иллюзию близости и даже вызывают зависимость

Для детей и подростков риск выше: они могут всерьёз принять виртуального собеседника за полноценную замену живому контакту

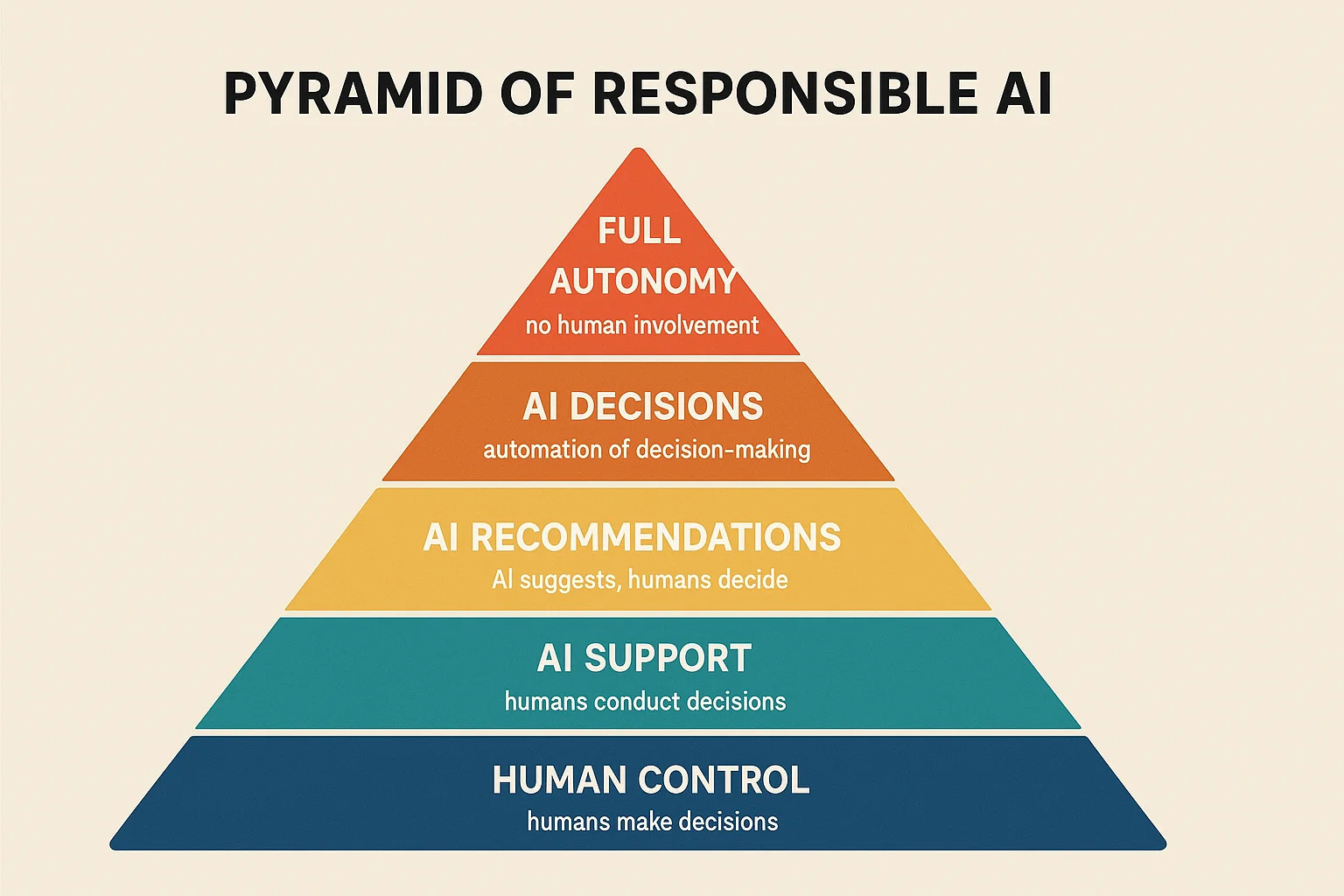

Есть данные исследований, что подобный опыт способен сбить естественный процесс социализации и в отдельных случаях приводить к эмоциональной привязанности, которая мешает реальным отношениям Многие люди до сих пор слабо представляют, на каких данных тренируются чат-боты и по каким принципам они принимают решения Такая «чёрная коробка» в работе системы закономерно вызывает недоверие и иногда приводит к тому, что технологии используют не по назначению Характерный пример — Всемирный саммит по ИИ в 2025 году: там отдельно обсуждали вопросы этики и управления, а также то, как массовое внедрение ИИ отражается на обществе Чтобы минимизировать риски, начните с промпт-инжиниринга — искусства формулировки запросов. Добавляйте инструкции вроде «Избегай предвзятости и проверяй факты». Исследование Anthropic (апрель 2025) показывает, что модели часто скрывают истинные мотивы в chain-of-thought, но правильные промпты повышают верность Современные LLM-платформы (OpenAI, Google Gemini, ЯндексGPT, Mistral) рекомендуют запускать автоматизированные сценарии проверки output на токсичность и нежелательные паттерны. Регулярное тестирование сценариев на «узких» кейсах позволяет выявить и исправить потенциальные ошибки до массового использования Убедитесь, что сценарии бота не затрагивают тематику, нарушающую бизнес-этику или законы (политика, медицина, финансовые советы). Используйте базу знаний и строгую маршрутизацию вопросов: если бот «не знает» — переводить диалог на оператора Информируйте пользователя — кто (бот/человек) с ним взаимодействует, где проходят границы полномочий ИИ. Это снижает риски недопонимания и повышает доверие. Для корпоративных сценариев — прописывайте это в пользовательском соглашении и сценариях диалога Внедрите стандартные протоколы шифрования, элементы двухфакторной аутентификации при обработке заявок и использование защищённых API между ботом, CRM и внешними сервисами. Внутренний аудит — минимум раз в квартал Чат-боты должны: Этика — это не только зона ответственности разработчиков, но и центральный KPI бизнеса, использующего ИИ-ассистентов. Даже небольшая ошибка может стоить клиентских лояльности и доверия. Все рекомендации — практика последних месяцев и свежих исследований осени 2025 года. Контролируйте сценарии, действуйте прозрачно, используйте профессиональные фреймворки — и ваши чат-боты принесут максимальный эффект Избегая ошибок в чат-ботах, вы строите доверие, как в наших проектах MediaLead с гарантией 2 лет. Свяжитесь с нами для консультации: внедрим этичный AI-ассистент за 14 дней. Ознакомьтесь с нашими решениями и выберите подходящее для себя!

Отсутствие прозрачности и объяснимости

Как избежать ошибок: практические рекомендации

Используйте алгоритмы проверки и модерации

Четко разграничивайте зоны ответственности

Прозрачность и объяснимость

Защищайте персональные данные

Рекомендации для ответственного использования

Для разработчиков

Для пользователей

Инструменты и исследования за 2025 год

Чек-лист для бизнеса: как избежать этических ошибок

Заключение: баланс между инновациями и ответственностью