Как я sitemap добавлял

Некоторое время назад, в дикой спешке, я добавил на сайт генерацию sitemap.xml. Но сделал это по всей видимости коряво. Результат - все страницы, которые в данный момент проиндексированы, давно уже не актуальны.

В тот момент карта сайта выглядела следующим образом:

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<url>

<loc>http://${domain}</loc>

<changefreq>always</changefreq>

</url>

<url>

<loc>http://${domain}/search</loc>

<changefreq>always</changefreq>

</url>

<url>

<loc>http://${domain}/items/create</loc>

<changefreq>weekly</changefreq>

</url>

<url>

<loc>http://${domain}/login</loc>

<changefreq>weekly</changefreq>

</url>

<url>

<loc>http://${domain}/register</loc>

<changefreq>weekly</changefreq>

</url>

<url>

<loc>http://${domain}/about</loc>

<changefreq>weekly</changefreq>

</url>

<url>

<loc>http://${domain}/agreement</loc>

<changefreq>weekly</changefreq>

</url>

<url>

<loc>http://${domain}/items/get/</loc>

<changefreq>daily</changefreq>

</url>

<url>

<loc>http://${domain}/company/</loc>

<changefreq>daily</changefreq>

</url>

</urlset>В тот момент я почему-то был уверен, что можно указать корневой URL, и все вложенные страницы тоже будет индексироваться этой записью. Т.е. указав

http://${domain}/items/get/я рассчитывал, что все подразделы тоже будут индексироваться,

http://${domain}/items/get/id1234

http://${domain}/items/get/id5678но по всей видимости это не так. Каждая страница должна быть указана отдельно.

Почитав рекомендации Яндекса, было принято решения все переделать. А заодно сделать так, чтобы робот сам подхватывал эти файлы через robots.txt.

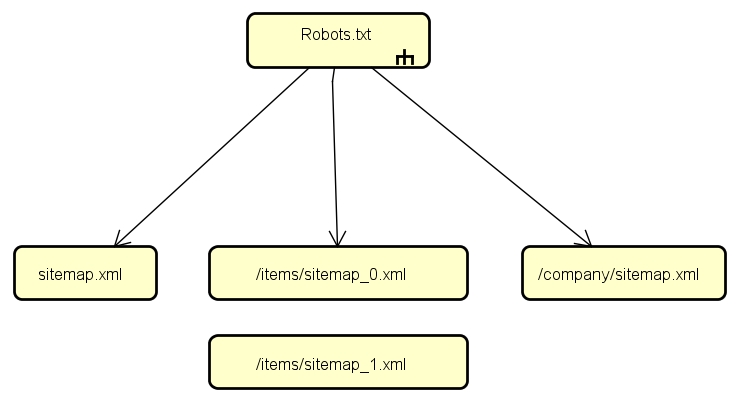

Я составил следующую структуру:

- У меня есть несколько плоских страниц в корневом разделе, таких как /login, /about, / и прочее. Их я укажу в главном sitemap

- Есть множество объявлений, для которых удобнее использовать свой собственный файл sitemap. При этом нельзя чтобы этот файл превышал 50000 записей и не весил больше 10Мб. Для этого я решил разбивать объявления на пачки по 20000.

- Для компаний нужно тоже иметь свой файл, ведь они так же могут превысить 50000 записей.

Так же рекомендуется указывать время последнего изменения страницы тегом . Как я понимаю, это позволяет роботу оперативно подтягивать изменения. А так же можно снизить нагрузку на сайт. Чем свежее страница, тем выше она должна располагаться в файле (я этого пока не сделал).

Robots.txt включает в себя все файлы sitemap. Это позволяет избежать ручного добавления этих файлов в веб-мастер.

Sitemap: http://$(domain}/Путь к файлу

Теперь нужно дождаться, когда поисковики проведут очередную ревизию. И проанализировать, насколько эти изменения помогли индексации страниц.