Топ-10 нейросетей для создания видео в 2025 году

1. Sora

Если вы хоть немного интересуетесь нейросетями, то наверняка слышали про Sora — флагманский инструмент от компании OpenAI для генерации видео. Его активно обсуждают маркетологи, креаторы, предприниматели и просто фанаты технологий. Но действительно ли он так хорош, как о нем говорят?

Sora — это ИИ для генерации видео, которая создает реалистичные короткие ролики (от 5 до 20 секунд) по обычному текстовому описанию. Работает Sora на базе GPT и других моделей OpenAI.

Sora умеет:

- создавать видео из текстового запроса на английском,

- генерировать сцену целиком, а не по кадрам — за счет чего ролик выглядит цельным,

- редактировать уже готовые ролики, менять детали, продлевать сцены или делать зацикленные фрагменты,

- подбирать шаблоны, стили, соединять разные фрагменты и управлять композицией с помощью функции Storyboard.

Sora особенно хороша в создании пейзажей, абстрактных паттернов и мультяшных роликов. Видео с людьми и животными получаются чуть менее реалистичными, особенно при активных движениях — но для многих задач это не критично. А вот если вы хотите добиться кинематографического эффекта или создать вау-ролик для соцсетей, Sora вполне справится.

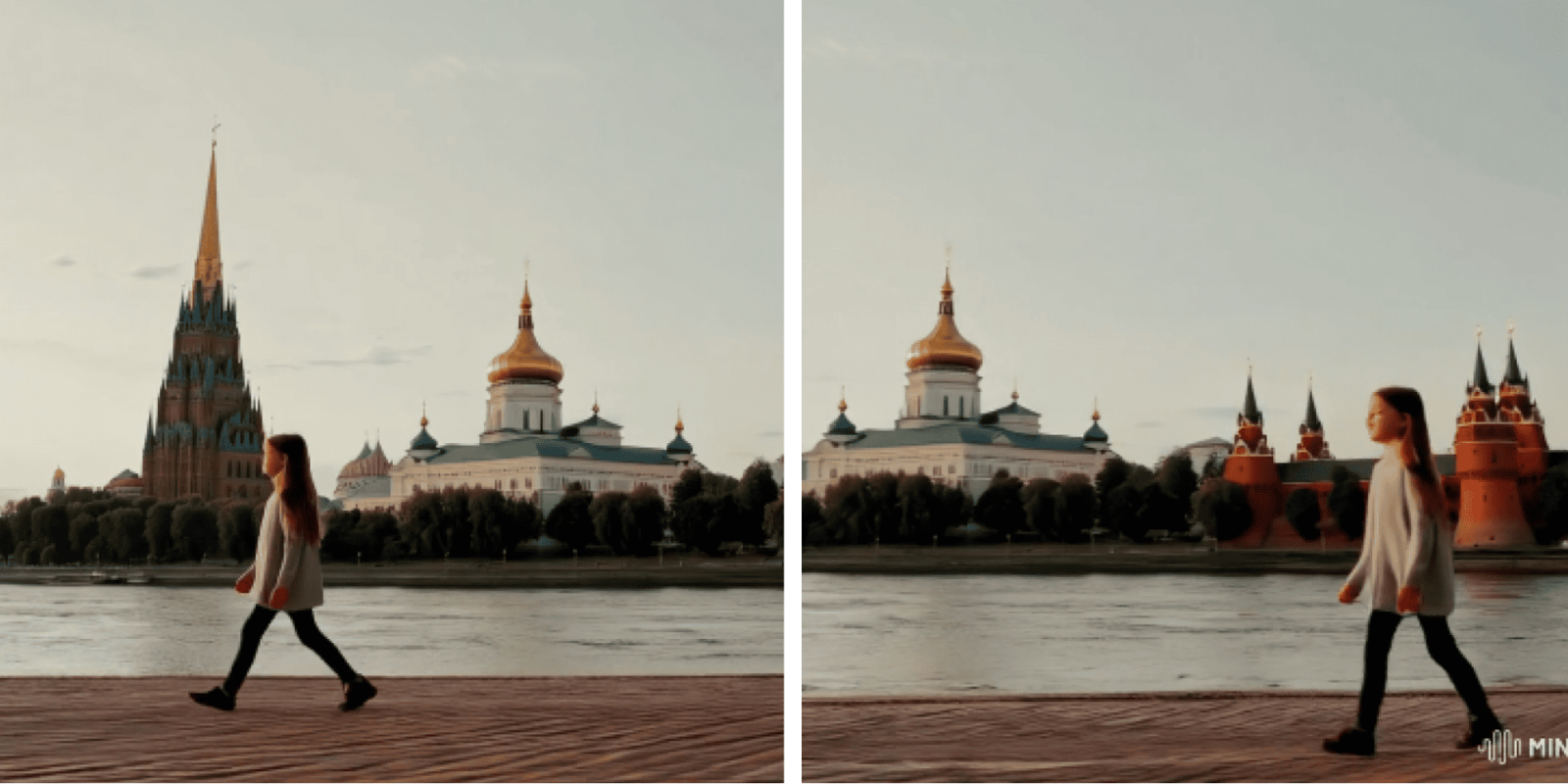

Чтобы работать с Sora, можно использовать этот ИИ-генератор видео: пишете, что должно быть в кадре — получаете ролик прямо в браузере. Veo 2.0 — это модель генерации видео от Google. Она работает на базе ИИ и интегрирована с Google Cloud. Позволяет пользователям создавать короткие ролики в разных стилях по текстовым подсказкам. Фокус — на визуальную реалистичность, сложные эффекты, движения камеры и работу со светом. У ИИ от Google есть ограничения. Например, нет AI-аватаров, то есть нельзя персонализировать ролик или использовать нужное лицо. Но нейросеть хорошо подойдет для визуально сложных коротких видео — промороликов, эстетичных заставок, mood-видео. Сработает для креативщиков и маркетологов, которым важна визуальная составляющая. Одна из фишек Vidu — создание видео по референсам. Можно загружать персонажей, объекты, окружение. Система Multi-Entity Consistency гарантирует, что все визуальные элементы будут органично сочетаться. Загружаете изображение, описываете нужную анимацию — и получаете полноценный ролик. Эта функция идеально подходит для сторителлинга, образовательных роликов и креативов. Можно действовать и через текст — описываете, что хотите увидеть. Создание видео занимает меньше 30 секунд. Платформа генерирует плавные движения, реалистичные переходы, масштабные эффекты и выразительную мимику. Даже лауреат премии «Оскар» продюсер Карл Рид отмечал, что Vidu справляется с 2D-анимацией. На скриншоте пример из мультяшного ролика по промпту Girl walking along the Moscow embankment. Kremlin in the background. Кремль не используется, но получилось почти без огрехов. В ИИ Runway третьего поколения можно создать видео, будто вырезанное из sci-fi фильма. А в режиме image-to-video платформа превращает фото в атмосферный монтаж с движением, плавными переходами и киноэффектами. На платформе доступна кастомизация — можно управлять темпом и переходами. Показывается превью в реальном времени — удобно следить за результатом. Можно загрузить личные фотографии, арты, рекламные баннеры — и на выходе получить динамичный ролик с мягкими панорамами и зумами. На скриншоте кадры из видео по загруженной фотографии девушки и промпту Girl walking along the Moscow embankment. Kremlin in the background. Главные отличия Stable Video Diffusion (SVD) от конкурентов — тщательная проработка стратегии обучения и масштабирование модели на огромных наборах данных. ИИ умеет генерировать ролики по текстовому описанию с кинематографической проработкой сцен, превращать статичные изображения в последовательность реалистичных кадров. Есть функция multi-view — создание нескольких согласованных ракурсов объекта. Инструмент Frame Interpolation позволяет плавно дополнять промежуточные кадры — чтобы повысить частоту видео. Используется контроль движения камеры (LoRA). Нейросеть Hailuo AI MiniMax позволяет генерировать полноценные креативы на основе одного изображения. Hailuo хорошо создает сцены, в которых требуется плавное, минималистичное движение. Например, медленный зум. Сложнее обстоят дела с быстрыми сценами: активным движением персонажей, резкой сменой ракурсов. Такие видео иногда требуют нескольких итераций и шлифовки промпта. Сложные действия — бег, танец — могут давать нестабильный результат. Но если использовать четкий и детализированный запрос, ИИ способен справиться и с этим. На скриншотах ролик по запросу Girl walking along the Moscow embankment. Kremlin in the background [Truck left, Pan right, Tracking shot] ИИ Kling хорошо справляется с простыми сценами и плавными действиями, но, как и большинство генераторов, сложно работает с быстрыми и сложными движениями вроде танцев или прыжков. Motion Brush — одна из самых интересных фишек этого ИИ. С ее помощью можно вручную задать траекторию движения объектов в кадре через рисунок прямо по изображению. Motion Brush отлично справляется с мелкими движениями, например, поворотами головы. При этом Kling может добиться похожего эффекта через промпт, но без такой точности. ИИ от Genmo четко следует текстовому сценарию: учитывает персонажей, окружение, ракурсы, стиль камеры и настроение сцены. Дополняет это реалистичная симуляция физики — ветер, волосы, вода, ткань, мимика. То есть с Mochi можно создавать короткие сцены с живыми персонажами и детализированным окружением. Mochi дает «управлять камерой»: прописывать панораму, зум, наклон и поворот, плавные переходы. Уровень динамики можно настроить от стабильного (50%) до максимально насыщенного движением (99%). Kandinsky 4.0 — логическое продолжение моделей Kandinsky 3.0/3.1 (text-to-image) и Kandinsky Video 1.0/1.1 (text-to-video). У «Кандинского» частично открытый код и бесплатный API-доступ. Что умеет русская бесплатная нейросеть для видео? Модель поддерживает реалистичные эффекты — свет, ветер, движение жидкости, блики. Можно прописать детали: мягкий фокус, кинематографическая глубина резкости. На практике, чтобы получить хороший результат, нужно несколько попыток. На каждую уходит примерно по 4 минуты. ИИ Шедеврум от Яндекса может генерировать четырехсекундные ролики с частотой 24 кадра в секунду в формате MP4. Чтобы получить ролик, пользователю нужно ввести текстовое описание задуманной сцены. Далее ИИ предложит четыре варианта первого кадра и набор анимационных эффектов, которые определяют стиль движения в ролике. На практике Шедеврум иногда отказывается выполнять запросы. Например, не хочет генерировать видео по промпту «Девушка гуляет по набережной Москвы, на фоне Кремль, естественное освещение». Но соглашается на запрос «Девушка гуляет по набережной Москвы». Первые кадры — изображения — получаются отличные, но при анимации ИИ иногда сливает человека с объектами, а сама картинка немного дергается. Подписывайтесь на наш ВК и Телеграм, чтобы узнавать последние новости SEO и подсматривать новые фишки продвижения. Несмотря на разницу в интерфейсах и технических возможностях ИИ, принципы построения промта универсальны для них всех:

2. Google Veo

3. Vidu

4. Runway Gen-3

5. Stable Video Diffusion

6. Hailuo

7. Kling

8. Genmo Mochi

9. Kandinsky

10. Шедеврум

Как правильно составлять промпты для генерации видео

Частые ошибки при составлении промптов для генерации роликов

Сравнение нейросетей для генерации видео