Приручить SEO: как мы автоматизировали SEO-процессы

SEO-рынок поменялся. Ручная работа уступает автоматическим решениям. И в этом нет ничего плохого. Главное — подходить к автоматизации с умом. Правильно настраивать автоматические системы, проверять данные и уметь их обрабатывать.

Рассказываю о наших излюбленных инструментах — и о том, как мы их используем, когда продвигаем и оптимизируем сайты клиентов.

Готовим сайт к оптимизации

Первое и самое важное — изучить сайт и проверить, насколько он готов к продвижению в поисковых системах. Для этого мы смотрим, оптимизирован ли сайт и соответствует ли он стандартам поисковиков.

Определяем уровень внутренней оптимизации

- Инструменты: Screaming Frog SEO Spider Tool и WebSite Auditor

- Время выполнения задачи: 20 минут

Почему именно эти программы

Коммерческое предложение мы готовим лишь тогда, когда понимаем объём предстоящей работы. Поэтому первым делом мы изучаем, как много ошибок на сайте клиента, и проводим мини-аудит.

Сначала импортируем основные SEO-данные сайта. Для этого используем парсеры Screaming Frog SEO Spider Tool и Website Auditor.

Первая программа есть в арсенале любого специалиста. Вторая не так популярна — это более узкий и специализированный инструмент. Мощное оружие, если знать, как с ним обращаться.

Мы тестировали десятки парсеров, остановились на связке этих двух: они прекрасно дополняют друг друга. Так, Website Auditor умеет проверять индексацию каждойстраницы — в SEO Spider и близко этого нет. В то же время, SEO Spider прекрасно парсит практически любую часть страницы сайта с помощью регулярных выражений.

Например — можно проверить, установлен ли счётчик Google Analytics на всех страницах. Так, когда мы анализировали сайт Siberian Health — нашего клиента, мы выяснили, что из ста тысяч страниц на четырёх тысячах (цифрами: 4 000!) не установлены счётчики. Как итог — клиент получал неполную картину посещаемости.

Начало пути: Screaming Frog SEO Spider Tool

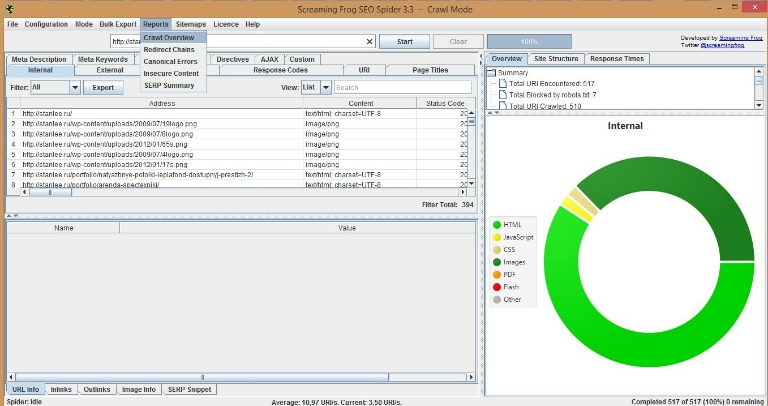

Выглядит это так.

В SEO Spider парсим данные сайта. Затем выгружаем в эксель-файл отчёт Crawl Overview — это общий обзор по ошибкам и уровню оптимизации сайта, без детализации. Но выгрузить отчёт недостаточно — надо его ещё объяснить. Для нас важно, чтобы клиент понимал каждый шаг и мог разобраться в данных.

Для этого мы корректируем отчёт. Программа экспортирует данные на английском языке. Там много специфических терминов и непонятных рядовому клиенту значений. Поэтому мы всё расшифровываем и поясняем в отдельном столбце.

Пример отчёта смотрите здесь.

WebSite Auditor: глубже в лес

Теперь, чтобы получить полную картину, нам нужны другие данные. Website Auditor нам в помощь.

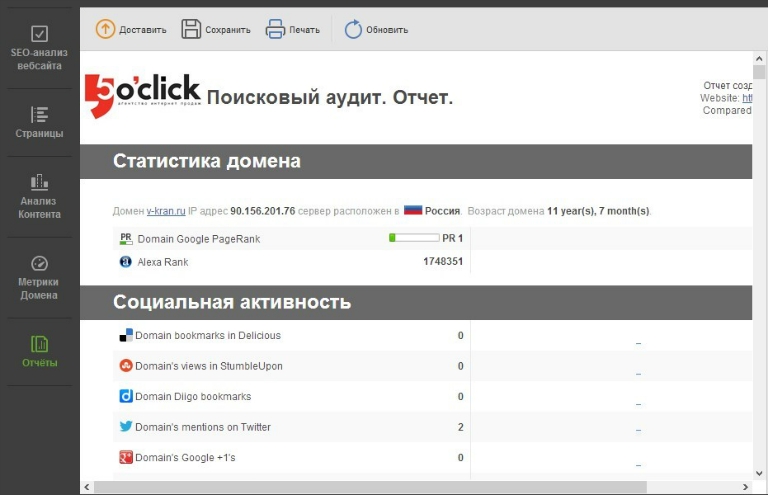

Парсим сайт. Программа анализирует десятки показателей: и метрики домена (авторитетность, посещаемость, глобальный рейтинг), и внутренние SEO-показатели каждой страницы, и упоминание в восьми социальных сетях (от Facebook до Diigo), и индексацию каждой страницы в четырёх поисковых системах.

После аудита мы выгружаем данные в PDF-файл. Затем готовим для клиента экспресс-аудит, где перечисляем критические ошибки оптимизации. И сохраняем эти данные в отдельной папке: всё это нам понадобится позже, когда будем проводить детальный аудит — по 161 пункту.

Экспресс-отчёт выглядит так.

Собираем семантическое ядро

Мини-аудит — этап предварительный. Настоящая работа начинается позже — когда мы собираем семантическое ядро. Именно от него зависит, насколько эффективно окажется продвижение.

Объясняю, почему. Пользователи находят ваш сайт по разным запросам. Допустим, вы продаёте гитары в Москве. Ваши покупатели вбивают в поисковики десятки фраз: и просто «гитары», и «купить гитару», и «продажа гитар», и «Москва гитары», и «гитары Martinez». Таких запросов — десятки и сотни. Запросы группируются в так называемые кластеры, а кластер ведёт пользователя на целевую страницу на сайте, которая уже оптимизирована под данную группу запросов. А семантическое ядро — это список всехсгруппированных запросов. Это суть, сердцевина вашего сайта.

Чем крупнее сайт и чем популярнее тематика, тем больше семантическое ядро.

Нередко после сбора ядра обнаруживается неожиданное — оказывается, что часть (и порой значительная) запросов сайт не охватывает. Тогда мы меняем структуру и дорабатываем сайт — создаём новые страницы и целые разделы под эти запросы. Потому что чем больше видимость сайта по поисковым запросам — тем больше у вас целевых посетителей.

А значит — больше продаж.

Генерируем запросы

- Инструмент: Надстройка PLEX для Экселя

- Время выполнения задачи: 10 минут

Если у вас камерный бизнес, по которому в принципе мало запросов, тогда всё просто. У антикварного магазина итальянской мебели в Санкт-Петербурге наберётся в лучшем случае несколько десятков запросов.

Другая ситуация — когда проект крупный, с тысячей страниц (например, интернет-магазин женской одежды), подобрать список базовых запросов недостаточно. Надо генерировать новые. Для этого мы формируем связки ключевых слов.

Допустим, продвигаем сайт с онлайн-курсами. Несколько десятков рубрик, а курсов — несколько тысяч. Ключевых слов здесь тысячи. Возможных связок — не меньше: «курсы» + «менеджмент, „курсы“ + „математика“, „курсы парикмахера бесплатно“, „курсы шахматы бесплатно“… и так — с каждой страницей, с каждой услугой.

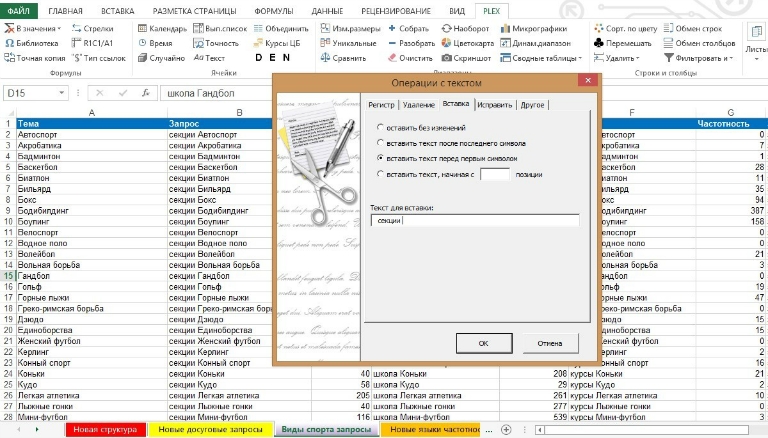

Главный вопрос — как генерировать запросы. Мы для этого используем надстройку PLEX для Экселя. Это мощный набор макросов, 50 инструментов, 60 формул и функций, которые позволяют быстро выполнить рутинную операцию.

Вернёмся к нашим курсам. Нам надо сгенерировать массив запросов с разными подстановками ключевых слов.

Открываем таблицу. Здесь выделяем нужные строки. Во вкладке PLEX находим пункт „Текст“ и вводим нужное нам слово, которое будет в начале или в конце запроса. На выходе — новый расширенный набор запросов, который мы будем использовать при продвижении.

Затем мы получаем данные от поисковых систем о популярности каждого запроса и отсеиваем наименее популярные.

Что делаем дальше?

Для каждой группы запросов определяем целевую страницу и оптимизируем её. Если целевой страницы для нужных запросов нет, мы создаём новую. Если нужно — вместо страницы делаем целую категорию.

Сравниваем оптимизацию страницы по запросу

- Инструмент: WebSite Auditor

- Время выполнения задачи: 10 минут

Для каждого сайта есть приоритетные запросы — те, которые дают наибольшую конверсию. На них мы сосредотачиваемся в первую очередь: выводим сайт клиента на первую страницу выдачи по важным запросам.

Помогаем нам Website Auditor.

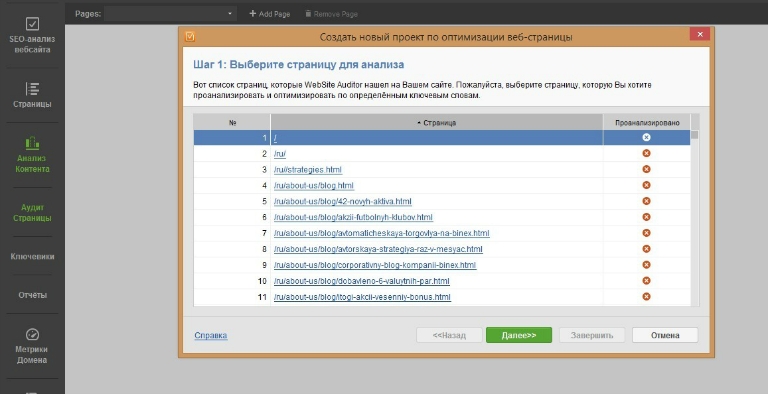

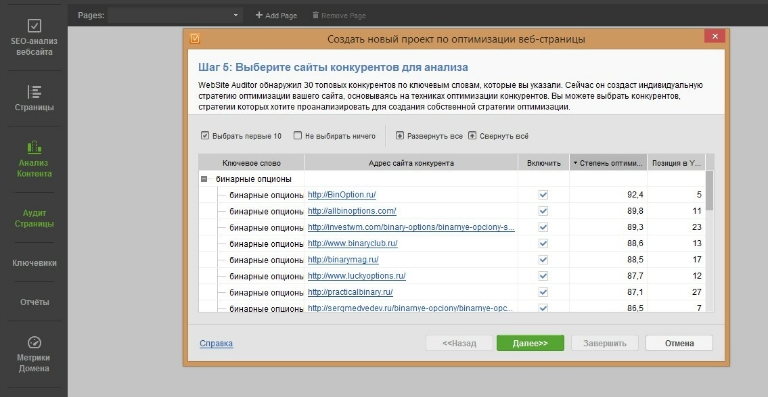

Загружаем в программе сайт. Затем во вкладке „Анализ контента“ выбираем целевую страницу для анализа.

Дальше вводим важные для клиента запросы. Выбираем поисковую систему и ждём, пока система соберёт данные.

А потом выбираем конкурентов, с которыми станем сравнивать нашу страницу.

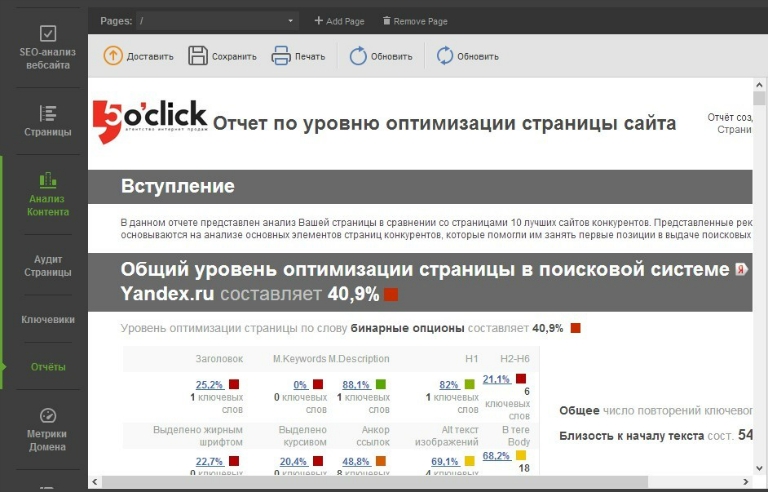

Во вкладке „Отчёты“ смотрим и анализируем данные. Если удобнее — экспортируем отчёт в PDF-файл.

Здесь мы видим, как программа автоматически рассчитала средний уровень оптимизации нашей страницы и одновременно — страниц-лидеров поисковой выдачи. В результате получаем наглядный сравнительный отчёт. И составляем рекомендации, как улучшить показатели оптимизации.

Идеальный вариант — уровень оптимизации в 100%. Это значит, что страница полностью оптимизирована под поисковые системы. И мы всегда достигаем этого уровня.

Добавляем страницы в индексы поисковых систем

- Инструменты: WebSite Auditor и Comparser

- Время выполнения задачи: 20 минут

Известная особенность Яндекса: он медленно (очень медленно) индексирует страницы. Если в Гугле страница появляется обычно в тот же день, то в Яндексе — чаще всего после одного-двух обновлений. А каждое обновление происходит раз в десять дней.

Из-за этого часто случается такое. Страницы созданы, уже оптимизированы, на каждой есть контент. Проходит одно обновление выдачи, второе, третье… а поисковые роботы нужные страницы не могут скачать. Индекс не обновляется. Страница не индексируется. Яндекс не видит её, а значит — и пользователи.

Возможные причины? Разнообразны. Возможно, контент редко обновляется на сайте. Возможно, во время разработки сайт был закрыт от индексации (привет, robots.txt). Возможно, страница содержит неинформативный контент. А может быть — на самом сайте нет ссылок на нужные страницы (а поисковый робот ходит только по ссылкам).

Очень важно найти неиндексированные страницы. Мы этим занимаемся, когда проводим технический аудит.

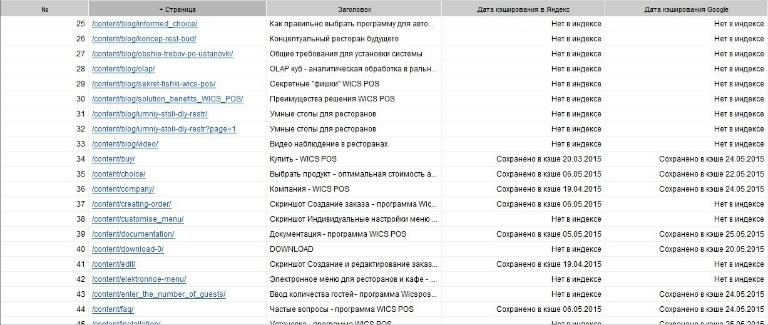

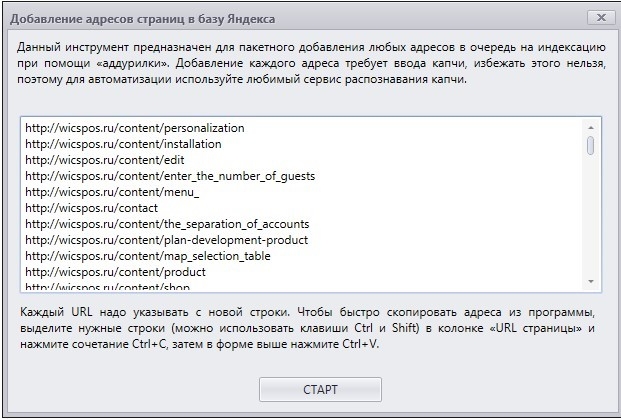

Когда сайт состоит из тысячи страниц, без автоматизации не обойтись. В Website Auditor мы определяем статус индексации каждой страницы. Затем создаём файл со списком страниц, которых нет в индексе поисковиков.

Затем отправляем адреса эти страниц в поисковые системы. Используем для этого форму ADDURL. В программе Comparser подключаемся к вебмастерам Яндекса и Гугла — и добавляем нужные страницы разом, списком.

Так мы передаём привет поисковым роботам и сообщаем, что на сайте появились новые страницы и их нужно проиндексировать.

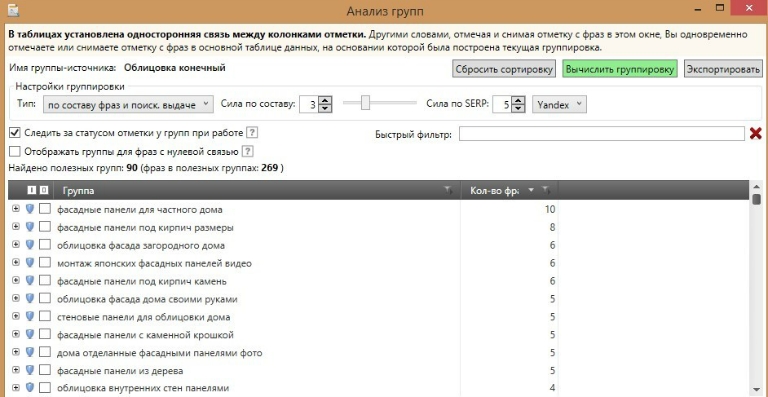

Группируем запросы

- Инструмент: Key Collector

- Время выполнения задачи: 20 минут

Итак, мы проиндексировали необходимые страницы, собрали список целевых поисковых фраз, и теперь нам надо обозначить для каждого запроса релевантную страницу. Если на сайте всего двадцать страниц — это легко сделать руками. Но такое встречается редко. За последние годы семантические ядра выросли, в среднем, с 50-100 запросов до 300-500. Часто мы собираем ядра и в две-три тысячи запросов.

Сколько времени уйдёт у специалиста, чтобы распределить на группы две тысячи запросов? Можно только гадать.

Мы экономим ресурсы. Эту задачу решаем методом кластеризации. Метод простой: программа собирает по каждому запросу данные из топ-10 поисковой системы, затем сравнивает списки URL. В зависимости от того, сколько нашлось совпадений URL из топ-10, программа определяет, можно ли отнести запросы к одной группе. Так за двадцать минут мы получаем файл со сгруппированными поисковыми запросами. Работаем в основном с Key Collector, но для больших ядер прибегаем к платному онлайн-сервису Rush Analytics.

Напоследок присваиваем каждой группе целевую страницу, на которую будем вести пользователей по нужным запросам.

Что дальше

На всё ушло полтора часа. Но это только начало пути.

Потом, когда все запросы собраны и сгруппированы, когда все целевые страницы созданы, когда оптимизация проведена, когда все страницы проиндексированы — тогда начинается основная часть работы. Самая интересная и непростая часть, моя любимая часть. Это продвижение сайта.

Но продвижение — отдельный разговор, и как мы это делаем — расскажу в другой раз.