SEO-аудит сайта самостоятельно: технический анализ и проверка внешних факторов

Часть 2 руководства по SEO-аудиту

Продолжаем разбирать особенности аудита сайтов. В первой части мы рассматривали структуру и контент сайта, а сегодня по плану технический аудит и проверка внешних факторов.

Для проведения технического аудита будут полезны следующие инструменты:

- Firebug (дополнение для браузера)

- Xenu Link Sleuth (десктопная программа)

- Screaming frog SEO spider (десктопная программа)

- RDS bar (расширение для браузера)

- панели вебмастеров Яндекс и Google

Технический аудит

Robots.txt — служебный файл, который содержит информацию для поисковых роботов. Должен быть доступен по адресу site.ru/robots.txt. Если этот файл отсутствует на сайте, то необходимо его создать.

В robots.txt можно указать следующую информацию для поисковых роботов: какие разделы сайта можно индексировать, а какие нет, главное зеркало, путь к карте сайта и т.д. Нет стопроцентной гарантии, что поисковый робот не проиндексирует "закрытые" от него разделы, но рекомендации он учёт. Подробнее про настройку можно почитать в Помощи от Яндекса или в Инструкции от Google.

Необходимо убедиться, что в robots.txt закрыты от индексации серверные логи, админ-панель сайта, корзина интернет-магазина, другие технические разделы. Но обратите внимание, чтобы были открыты для ботов поисковиков скрипты сайта и CSS.

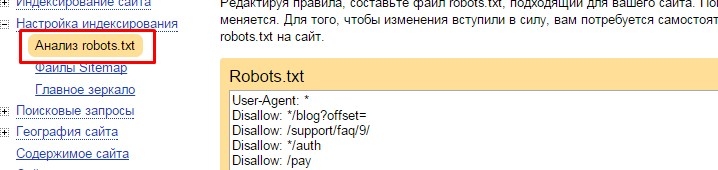

Проверить, какие разделы и страницы робот будет индексировать, а какие нет, можно, например, в кабинете Вебмастера Яндекса:

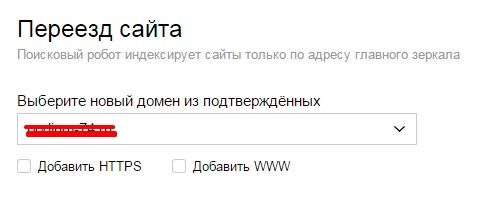

В бета-версии Вебмастера Яндекса проверьте главное зеркало сайта. Укажите основной домен для Яндекса в robots.txt, воспользовавшись директивой Host. Например: Host: site.ru

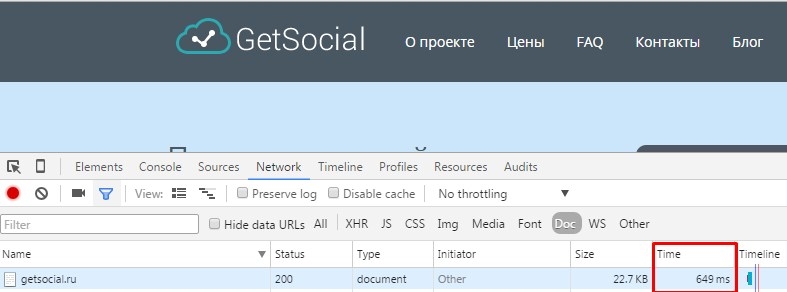

При проведении технического аудита, необходимо замерить скорость загрузки страниц сайта. Например, в браузере Chrome можно быстро посмотреть скорость загрузки следующим образом F12→ Network→Doc→Time. Хороший результат — скорость загрузки меньше 1 секунды.

Далее проверяем код сайта на отсутствие мусора: скрытого текста, закомментированных блоков, каких-либо невидимых в публичной части элементов. Бывали случаи, когда недобросовестные оптимизаторы размещали в коде клиентского сайта скрытые от глаза пользователя тексты спамного содержания. Из-за чего сайт терял позиции в поисковых системах. Поэтому проверьте свой сайт не только с позиции пользователя, но и взглянув на него “глазами поискового робота”.

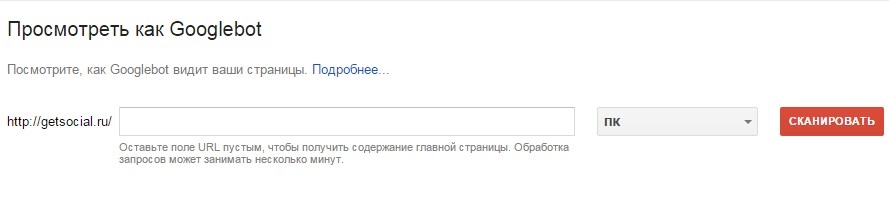

В Google Search Console можно посмотреть на сайт, как Googlebot:

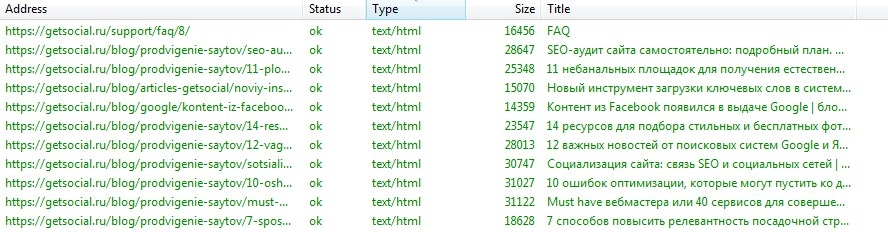

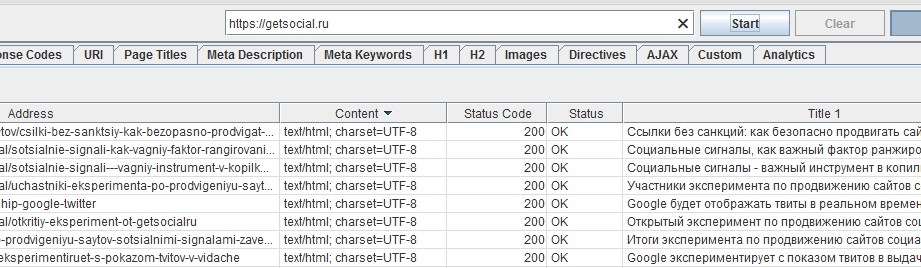

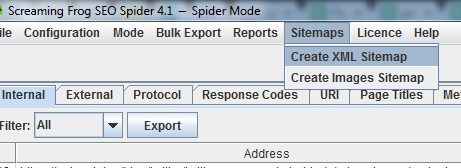

Проверка URL-ов сайта может быть выполнена с помощью программ Xenu Link Sleuth или Screaming frog SEO spider.

Программа просканирует страницы вашего сайта и вы увидите все URL-ы, метатеги и заголовки, статусы страниц, сможете найти битые ссылки, редиректы, входящие и исходящие ссылки для страницы, посмотреть уровень вложенности страниц.

программа Xenu

Для начала просмотрите URL-ы страниц. Будет лучше, если у сайта настроены ЧПУ (человекопонятные урлы), например так: https://spark.ru/startup/getsocial-ru/blog. Убедитесь, что адреса страниц постоянные, а движок сайта не генерирует дубли страниц.

программа Screaming frog

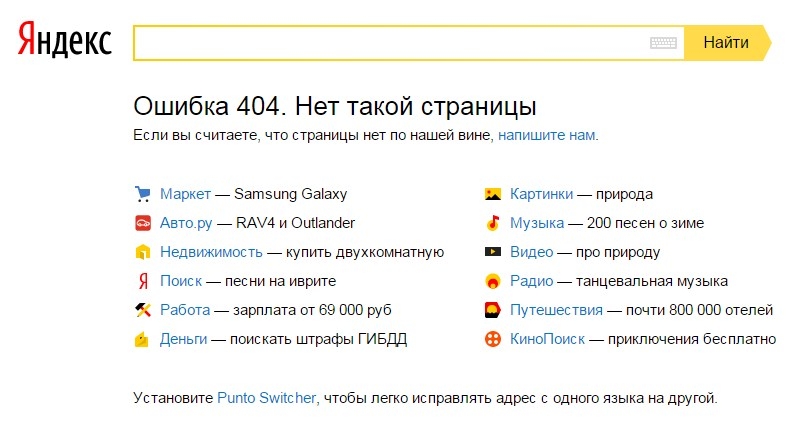

С помощью этих программ вы сможете найти страницы с ошибкой 404 и битые ссылки. Ссылки, ведущие на несуществующие страницы нужно устранять, чтобы пользователь попадал в нужный ему раздел, а не на страницу ошибки.

Что касается самой страницы 404 ошибки, то она должна быть оформлена, чтобы помочь пользователю сориентироваться, если уж он на неё попал. Обычно на ней размещают объяснение, что страницы с таким адресом нет и предлагают воспользоваться поиском по сайту, перейти на главную страницу или в основные разделы сайта.

Если по каким-то причинам нужно изменить URL-ы сайта, то, чтобы не возникало большое количество 404 ошибок, настройте редиректы со старых адресов на новые.

Проверьте наличие корректного sitemap. Многие движки сайтов позволяют настроить сайтмап, который будет автоматически обновляться, при внесении изменений на сайт (например, добавлении новых страниц). Подробно про карту сайта можно почитать здесь. Ссылку на sitemap укажите в файле robots:

Sitemap: http://site.ru/sitemap.xml

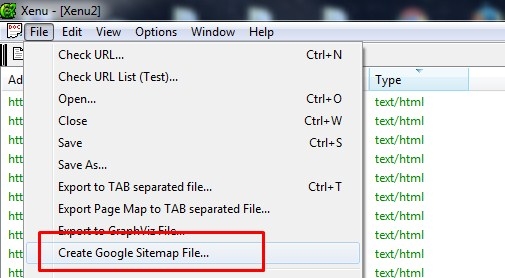

Сгенерировать карту сайта помогают программы Xenu и SEO frog:

Программа Screaming frog может сделать sitemap с учетом файла robots.txt, чтобы не включать в него разделы сайта, которые вы закрыли для индексации.

Анализ внешних факторов

Аудит внешних факторов прежде всего включает в себя проверку обратных ссылок сайта.

Инструменты:

- сервисы Majestic SEO, Ahrefs, MegaIndex.com

- Яндекс Метрика

- Гугл Аналитика

- панели вебмастеров Яндекс и Google

Зачем нужен анализ бэклинков? Ссылки — один из важных факторов ранжирования сайта. И если сайт существует не первый день, то он скорее всего имеет ссылочную массу. Указанные выше сервисы: Majestic SEO, Ahrefs, MegaIndex.com — помогут с аудитом бэклинков.

Что нужно учесть при аудите?

1. количество входящих ссылок

2. анкор-лист

3. типы ссылок

4. типы и траст доноров

скриншот из системы MegaIndex.com

Количество обратных ссылок может быть разным, но если на ваш ресурс ведут сотни и тысячи бэклинков, то обязательно следует учесть рекомендации ниже.

Основные требования поисковых систем к ссылочному профилю сайта:

- разнообразный анкор-лист: если раньше анкоры ссылок были в основном тестовые и с содержанием ключевых слов, то сейчас нужно сделать упор на разнообразие. Желательно включить в анкор-лист и такие слова, как: читать, смотреть, здесь, тут, подробнее и т.д.;

- также имеют значение типы ссылок: не стоит пренебрегать безанкорными ссылками и бэклинками с изображений;

- разнообразие доноров ссылок: среди источников обратных ссылок должны быть не просто какие-то площадки с сапы, а сайты партнеров, поставщиков продукции, электронных СМИ, тематических каталогов, социальных сетей, форумов, порталов товаров и услуг и т.д.

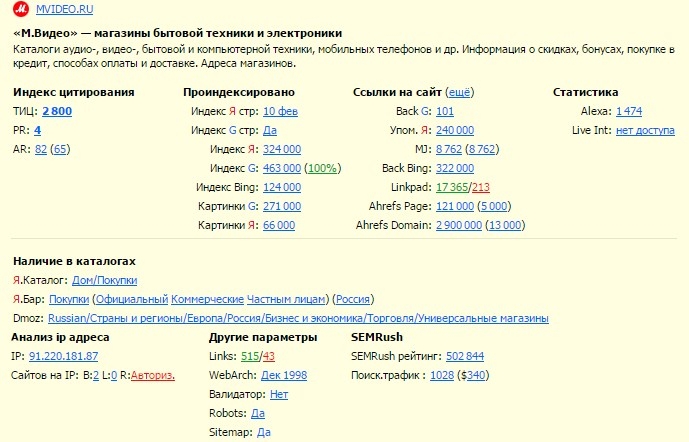

- траст доноров: лучше, если источниками ссылок будут сайты, которые уже имеют какой-то положительный вес в сети, чем ресурсы под фильтром АГС. Поэтому нужно проверять доноров, перед размещением ссылок. В быстром анализе донора поможет расширение для браузера RDS bar.

Расширение покажет основные данные по сайту: количество проиндексированных страниц, количество входящих и исходящих ссылок по Linkpad, ТИЦ (и наложен ли на сайт фильтр АГС), PR, наличие сайта в каталогах, дата вебархива и т.д.

Социальные факторы тоже должны быть учтены при проведении аудита. Посмотрите упоминания сайта в социальных сетях при помощи поиска Яндекс Блоги.

Одни из важных социальных факторов:

- присутствие странички вашей организации в соцсетях;

- упоминание сайта в социальных сетях;

- ссылки из соцсетей (в постах на стене, комментариях и т.д.);

- использование социальных кнопок на сайте;

- использование авторизации на ресурсе через соцсети.

Поведенческие факторы

При помощи ЯндексМетрики или Google Analytics оцените поведение пользователей на сайте.

Что нужно учесть при анализе поведенческих факторов:

- показатель отказов (продвигаемые на сайте страницы должны отвечать запросам пользователей, иначе человек сразу уйдет с сайта и это будет засчитано за отказ);

- время на сайте (посетитель должен провести на сайте достаточное количество времени, чтобы ознакомиться с информацией);

- глубина просмотра (если пользователь смотрит несколько страниц сайта, значит он заинтересован, но не стоит усложнять структуру сайта, чтобы увеличить этот показатель. Иначе посетителя можно отвлечь от основной цели — произвести конверсионное действие);

- конверсия форм (обратите внимание на то, насколько просто пользователь может сделать заказ с сайта или заполнить какую-либо конверсионную форму);

- возвращение к поиску (если пользователь вернулся к поиску после посещения вашего ресурса, значит он не нашел то, что искал и сайт не отвечает на его запрос, и это может привести к понижению сайта по данному запросу в выдаче);

- связь позиций сайта и количества переходов из поиска (если ваш сайт на первом месте, а заходов по нему слишком мало, с учетом частотности запроса, значит с сайтом что-то не так. Возможно, у ресурса некорректный сниппет в выдаче);

- перемещение пользователя по сайту (Вебвизор в Яндекс Метрике позволит понаблюдать за поведением пользователя на сайте);

- использование социальных кнопок на сайте (социальная активность — это хороший поведенческий показатель, если вашим сайтом делятся в соцсетях, значит он интересен посетителям);

- отзывы и комментарии (это и уникальный контент для вашего сайта, и обратная связь с пользователями).

P.S.

Как видите, очень много моментов нужно учесть при проведении аудита сайта. Но пренебрегать анализом ресурса нельзя, ведь сам сайт “живёт” и меняется, а значит нужно следить, чтобы не появлялись страницы с ошибками, не ломалась структура сайта, были актуальными сайтмап и robots.txt. Сайт должен быть удобным для пользователей, а информация на нём - актуальной. Когда обновляются алгоритмы поисковых систем, ресурс должен соответствовать требованиям поисковиков.