Как тестировать объявления контекстной рекламы на малых объемах [советы и кейсы Promopult]

«Тестирование объявлений — это не для малого бизнеса. У нас нет ни денег, ни людей — кто и за чей счет этим будет заниматься? Да и трафика мало — результаты не будут достоверными...».

Примерно так специалисты говорят о тестировании объявлений в малом бизнесе.

И в чем-то они правы. Если тестировать руками, то застрянешь в рутине. Плюс методологические проблемы — надо понимать, что и как делать. А если обратиться в агентство, то отдашь немало денег (например, здесь мы рассказывали, как агентства съедают до 80% рекламного бюджета).

Что же остается? Надеяться, что исходные варианты объявлений будут «ничего»? Потихоньку править проседающие объявления наугад?

Мы с этим не согласны. Совсем. И мы докажем, что тестирование в малом бизнесе вполне возможно (и может не стоить их владельцам ни секунды времени).

Что такое А/В-тестирование объявлений и что оно дает

Идеальных объявлений не бывает — кто бы их ни составлял. Всегда можно нарастить CTR, позиции и уменьшить цену клика.

А/В-тестирование (сплит-тестирование) — это способ выявить более удачные варианты объявлений из двух возможных.

Как оно происходит:

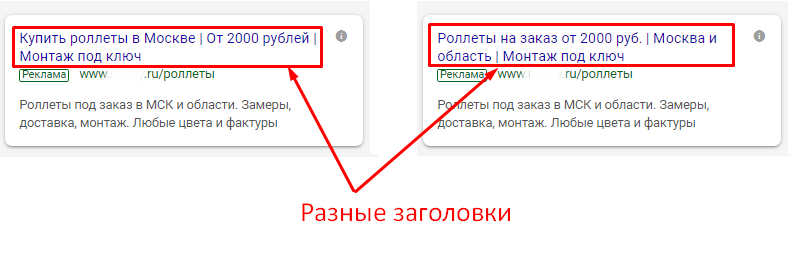

- создаете два варианта одного и того же объявления, но с отличием (другим заголовком, текстом, быстрыми ссылками и т. п.);

- запускаете в показ параллельно старое и новое объявление (обычно аудитория делится 50/50 — то есть половина видит текущее объявление, половина — тестируемое);

- по результатам тестирования сравниваете целевые показатели (CTR, конверсия, стоимость клика и др.);

- если тестируемое объявление показало лучший результат, то оно запускается в показ вместо текущего; если нет — повторяете тестирование с другим вариантом объявления.

В теории тестировать объявления можно бесконечно — даже если вы получили позитивный результат, можно еще что-то улучшить.

Но на практике после достижения положительного результата тестирование обычно прекращают. Все-таки это затратный процесс. И если вы добились роста CTR, скажем, с 3% до 8%, то дальнейшие тесты могут не дать заметного эффекта.

Технология тестирования по своей сути проста. Но когда доходит до дела, начинаются проблемы. И это не только нехватка рук.

Что не так с тестированием объявлений в небольших масштабах

Допустим, вы запускаете с утра тест и к вечеру получаете такие цифры:

| Показы | Клики | CTR | Текущее объявление | 33 | 5 | 15% | Тестируемое объявление | 24 | 0 | 0% |

Казалось бы, что тут думать — тестируемое объявление проиграло.

Если бы объявления показывались «в вакууме» — без влияния каких-либо факторов — то так бы и было. Увеличение показов приводило бы к пропорциональному росту кликов.

Но в реальности есть масса факторов, влияющих на результаты. Поэтому результаты тестирования должны быть статистически значимыми.

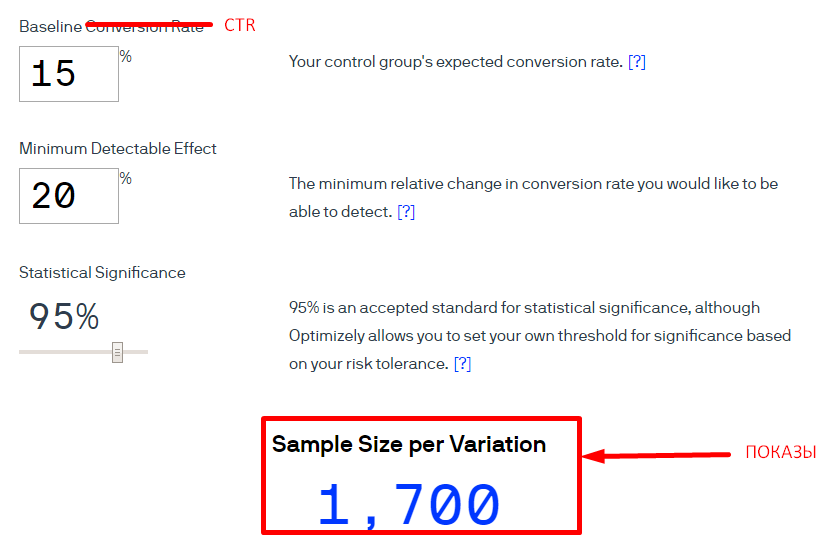

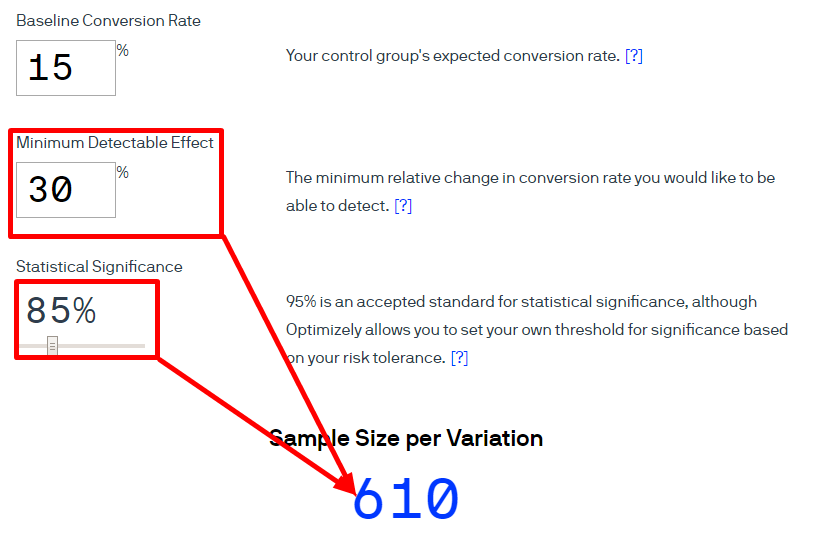

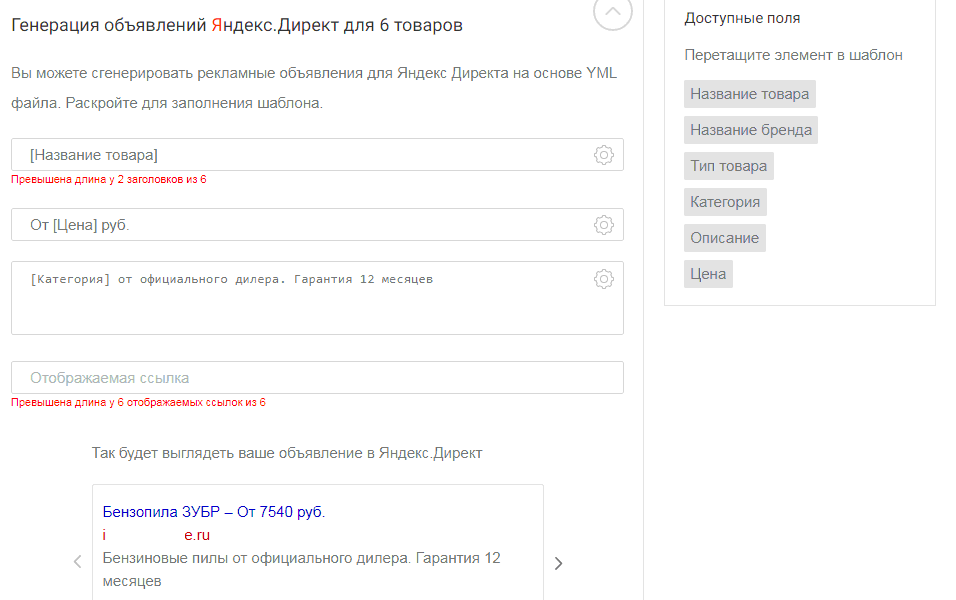

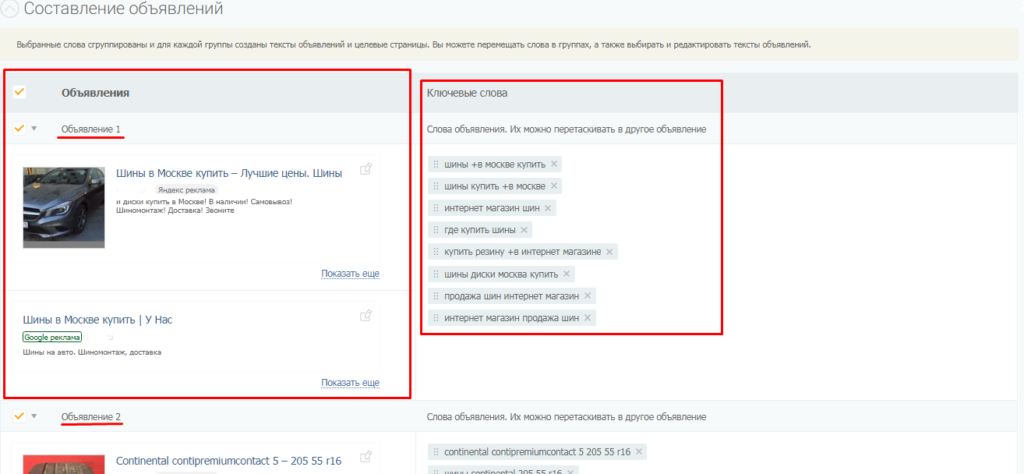

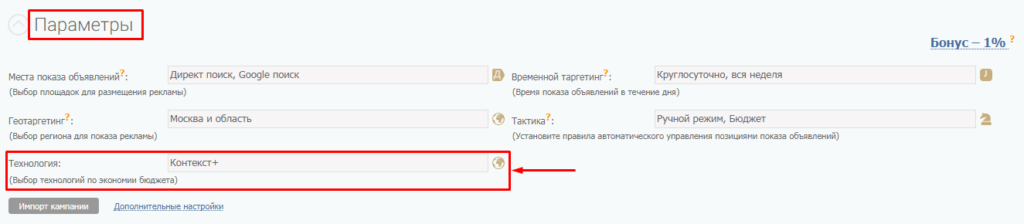

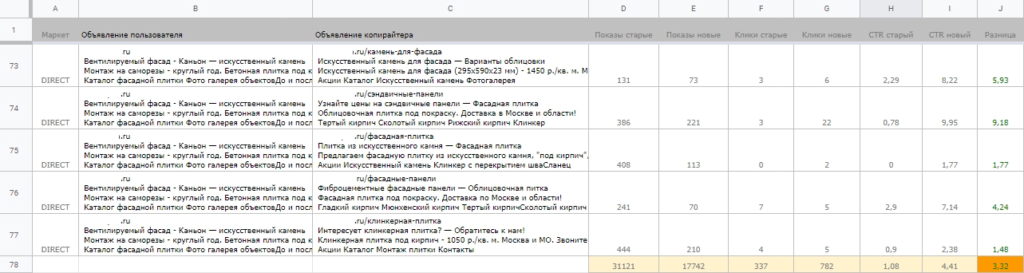

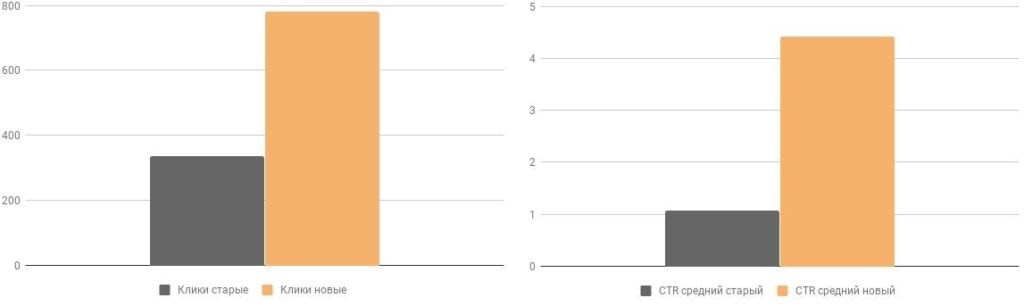

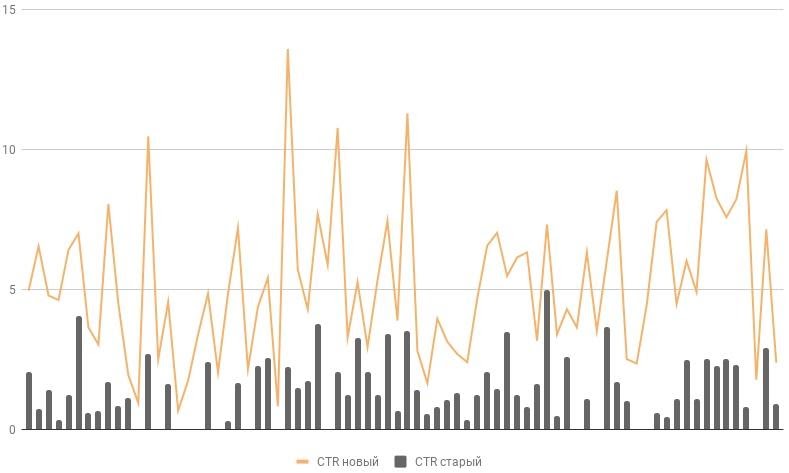

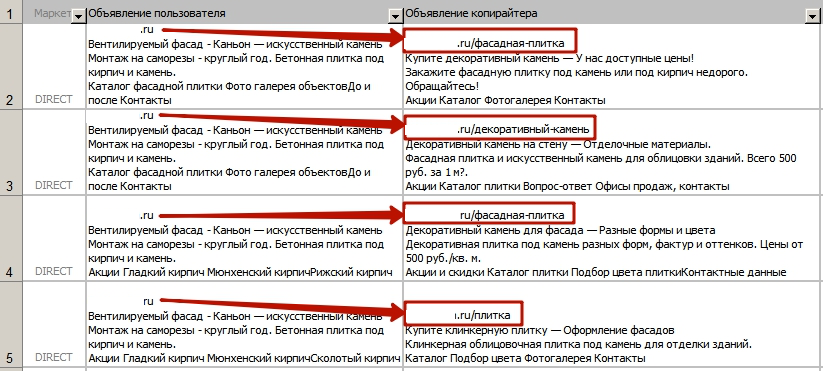

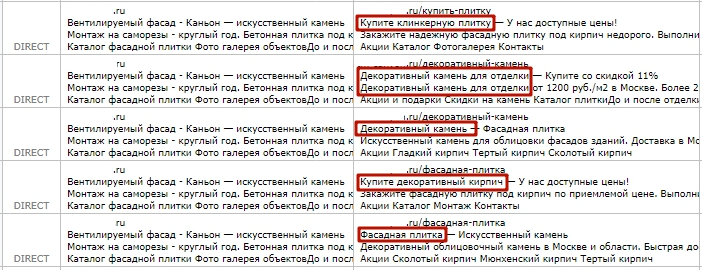

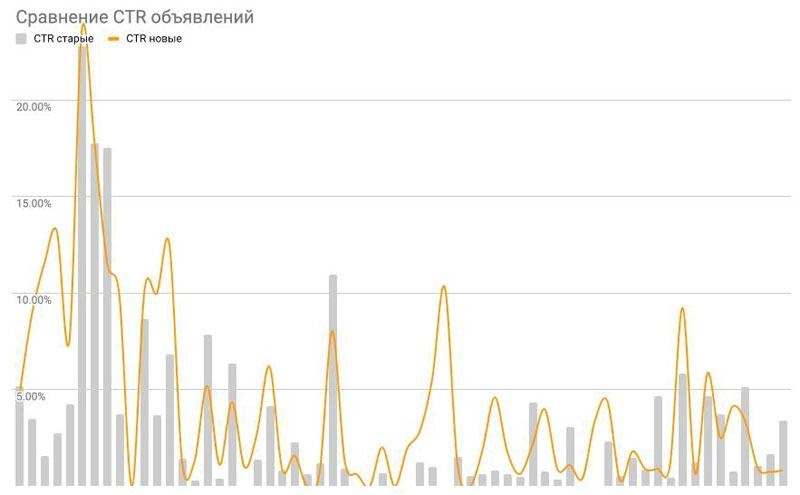

Открываем калькулятор размера выборки для А/В-тестирования и огорчаемся: Если бы мы показали объявление 1700 раз, и CTR составил около 15%, то это этот результат был бы статистически значимым. У нас же всего 33 показа. Разница очевидна. Продолжаем тестирование и получаем такие результаты: Видим, что тестируемое объявление обошло текущее по CTR. Так в чем проблема? Рассчитали объем выборки — запустили тест — получили статистически значимые результаты — приняли решение. Но посмотрим на этот процесс глазами владельца малого бизнеса с условными 40 тыс. руб. в месяц на контекстную рекламу: Столько ждать никто не будет. Нужны способы ускорения тестирования и получения значимых (насколько это возможно) результатов на малых выборках. Обычно статистическая значимость принимается на уровне 95%. Но в случае с малыми выборками приходится чем-то жертвовать. Понизьте ее до 90% или даже до 85%. Не самый изящный ход — но он работает. На малых бюджетах нет возможности выверять все до миллиметра и тестировать каждое слово в объявлении. Переделайте полностью объявление — заголовок, текст, быстрые ссылки, отображаемый URL. Так вы будете сравнивать абсолютно разные объявления. И какие-то из них обязательно сработают. Если объявление получило 5 кликов в течение трех минут, то это может быть результатом скликивания (недобросовестных манипуляций) или случайных нажатий. Те же 5 кликов, полученные в течение всего дня, позволили бы с большей уверенностью судить о закономерности. Перфекционизм — это хорошо. Но когда ожидаемые затраты превышают ожидаемый эффект, пора остановиться. Направьте ресурсы на улучшение сайта и другие источники привлечения клиентов. Проранжируйте объявления по уровню CTR. Начните с объявлений с самым низким CTR и двигайтесь вверх по списку. Если вы решили самостоятельно тестировать объявления, автоматизируйте их составление. Для этого есть, например, бесплатный генератор из YML — он подходит интернет-магазинам и другим сайтам, у которых настроена выгрузка товаров/услуг в XML. Подробно о работе с генератором объявлений читайте в этой статье. Также генератор объявлений есть в модуле контекстной рекламы PromoPult — достаточно добавить сайт и собрать ключи с помощью автоподборщика. Система самостоятельно сгруппирует ключи путем их кластеризации и составит объявления для каждой группы — для Яндекса и Google. Подробно работу генератора объявлений в PromoPult мы описывали в статье «Как бесплатно сгенерировать объявления для контекста». Если же вы вообще не хотите касаться тестирования и связанных с ним работ, используйте технологию, которая на 100% его автоматизирует. Она доступна в системе PromoPult. Разберем ее подробно. «Контекст+» — это технология от рекламной платформы PromoPult, направленная на повышение CTR рекламных кампаний в Яндексе и Google. Работает технология в двух направлениях: Технология подходит кампаниям даже с малым трафиком. Специально разработанный алгоритм определяет, какого объема выборки достаточно в каждом конкретном случае для получения статистически значимых результатов. Технология «Контекст+» по умолчанию подключена для всех кампаний, запускаемых в модуле контекста PromoPult. Какого-либо сложного управления нет — только один пункт на первом шаге настройки кампании. Если по какой-то причине вы отключили технологию «Контекст+», советуем подключить ее. Почему? Объясним на примере кейсов. Это кейс о бизнесе, который рекламируется в сложном регионе. В итоге за полгода удалось нарастить CTR на 308%. Исходные данные: На момент запуска тестирования средний CTR по кампании составлял 1,08%. После тестирования — 4,41% (рост на 3,32 п.п.). То есть кликабельность объявлений возросла на 308%! Примечательно, что CTR удалось повысить по всем объявлениям. По некоторым из них рост составил 13 и даже 18 раз. Добились роста CTR разными способами: С полным описанием кейса вы можете ознакомиться по ссылке. Это кейс о региональном бизнесе с микробюджетом на контекст, который получил двойной рост CTR при малом количестве объявлений. Исходные данные: Средний CTR по кампании на начало тестирования составлял 2,97%, после — 6,27%. Прирост — 3,3 п.п. (+111%). По отдельным объявлениям кликабельность выросла в 4-6 раз. Детальный разбор кейса — по ссылке. Примечательный кейс — здесь приведены данные всего за 1 день тестирования. Исходные данные: Средний CTR до тестирования был 2,01%, после — 2,44%. Прирост CTR по кампании — 0,43 п.п. (21,44%). 21,44% — это прирост по всем объявлениям (были еще те, по которым CTR не вырос). Технология «Контекст+» работает непрерывно: объявления, которые не показали роста, тестируются повторно — пока не будет позитивного результата. По 39 объявлениям был прирост — всего за один день удалось повысить их CTR на 112%. Максимальный прирост CTR по конкретному объявлению зафиксирован на уровне 10,46 п.п. (480%). Детальный разбор этого кейса с пояснениями о том, как улучшали объявления, читайте здесь. Для вас как рекламодателя технология автоматизирована. Для тестирования быстрых ссылок, текстов и кросс-минусовки ничего не нужно делать — CTR объявлений растет, по сути, в фоновом режиме. Но за работой технологии стоят живые люди, которые пишут тексты вручную. Поэтому технология платная — она стоит 10% от рекламного бюджета. Ожидаемая экономия бюджета за счет роста CTR — до 45%. Важно! Технология тем эффективней, чем выше бюджет. При росте бюджета увеличивается объем данных для анализа. Мы не рекомендуем подключать «Контекст+» с бюджетом менее 3000 руб.

Показы Клики CTR Текущее объявление 1986 58 2,9% Тестируемое объявление 2294 112 4,9% Как тестировать объявления при малом трафике

Уменьшите уровень значимости

Вносите радикальные изменения

Отслеживайте результаты в динамике

Не экспериментируйте на объявлениях с CTR выше среднего

Используйте системы автоматизации

Автоматическое тестирование объявлений с помощью технологии «Контекст+»

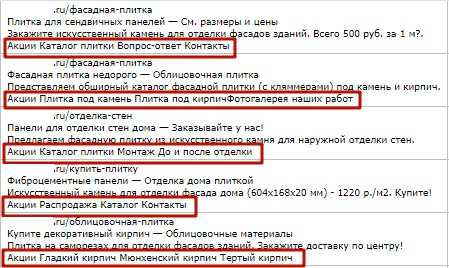

Кейс 1. Производитель фасадной плитки из искусственного камня — прирост CTR +308%

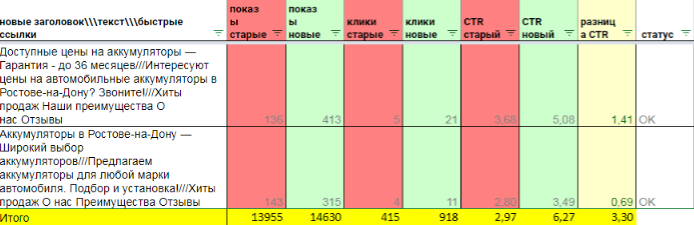

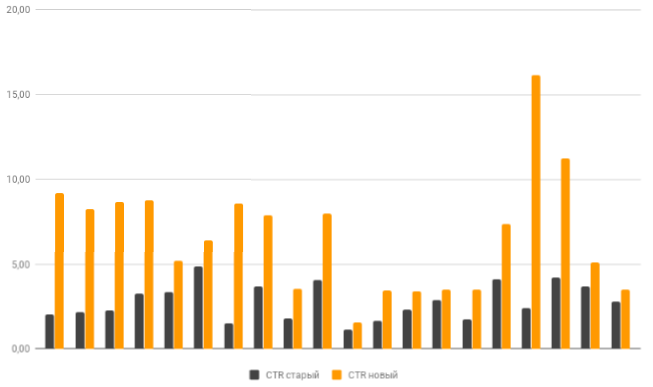

Кейс 2. Магазин автомобильных аккумуляторов — прирост CTR +111%

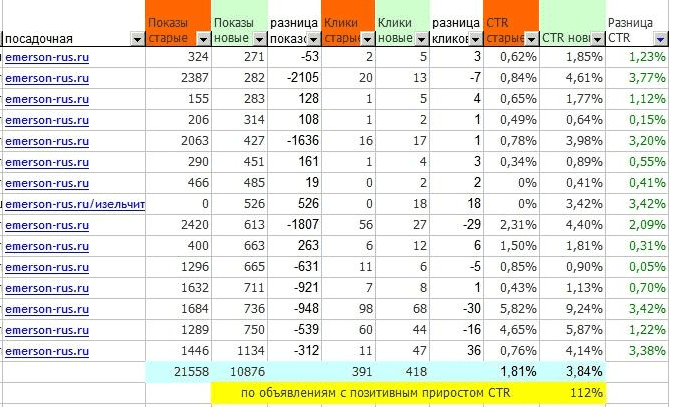

Кейс 3. Компания по продаже измельчителей пищевых отходов — прирост CTR +21% (за один день)

Сколько стоит технология «Контекст+»