Нейросетевые галлюцинации: ошибки искусственного интеллекта и их причины

Однако, если примитивные роботы и способны минимизировать риски возникновения неполадок, четко выполняя поставленные задачи без усталости и выгорания, то современные устройства, использующие искусственный интеллект, так же как и люди, могут допускать ошибки. В данной статье мы обсудим эти сбои.

Галлюцинации нейросетей — что это

Галлюцинациями, аналогично психическим явлениям у человека, называется феномен, при котором нейросеть выдает недостоверные данные. Искусственный интеллект находит в своем массиве информации ложные закономерности и создает изображение или текст, которые частично или полностью не соответствуют исходному запросу.

Alt=галлюцинации у искусственного интеллекта

Нейросеть «Кандинский» изображает галлюцинации так.

Галлюцинации можно считать результатом «творческого» процесса нейросетей. Как известно, искусственный интеллект не способен создавать что-либо принципиально новое, он лишь комбинирует существующие данные, ориентируясь на первоисточник. Однако, когда в работе нейросети происходит сбой, эти комбинации могут стать нетипичными и привести к результатам, которые трудно соотнести с реальностью.

Это напоминает творчество человека: его определение также подвергалось изменениям на протяжении истории. В XVIII веке творчество рассматривалось как подражание природе, в XIX — как создание нового. В эпоху постмодернизма творчество сравнивается с игрой в конструктор: когда уже существующие элементы комбинируются в новые формы. Такой процесс удивительно похож на работу нейросетей.

Различные источники называют несколько основных причин возникновения галлюцинаций в выдаваемых искусственным интеллектом ответах:

- Недостаточное обучение

ИИ работает с массивами информации, загруженными в базу в процессе обучения. Если объем этих данных небольшой, у нейросети не будет правильных ответов на некоторые вопросы. А так как модель подбирает не достоверный, а наиболее вероятный вариант, результат часто далек от ожиданий.

Так, когда ChatGPT начал поддерживать на русский язык, он отвечал частично на английском, потому что русского текста в базе данных было недостаточно.

2. Некорректная вводная информация

Искусственный интеллект обучается не только на научных публикациях, но и на прочих материалах. Чтобы ответы были более реалистичными, используют посты из блогов, художественные произведения и стенограммы устной речи. В таких текстах информация часто оказывается неполиткорректной или ошибочной.

Например, Bing Chat (предшественник Copilot) был известен склонностью к оскорбительным и расистским высказываниям по отношению к пользователям до того, как его дополнили специальными фильтрами.

3. Избыточное обучение

Во

время взаимодействия с пользователем нейросети получают новую информацию,

которую затем учитывают при формировании ответа, также они часто работают над

одними и теми же задачами. Из-за этого ИИ становится узкоспециализированным, и теряет

возможность качественно выполнять работу, не связанную с обозначенной темой. Alt=анекдот

про ошибки нейросетей Этот

самокритичный «анекдот» прекрасно иллюстрирует, как у ИИ возникают галлюцинации

из-за переобучения. Искусственный

интеллект также может начать обучаться на сгенерированной им же или другими

нейросетями информации и деградировать из-за этого. В ранних версиях Midjourney

и ChatGPT это происходило после пяти циклов обучения. Явление получило название

Model Autophagy Disorder (сокращенно MAD). Так, для

нормального функционирования искусственному интеллекту необходим созданный

человеком оригинальный

контент и разнообразные задачи от пользователей. 4. Сам принцип работы Нейронные

сети составляют предложения, опираясь на вероятность следования одного слова за

другим. Этот способ позволяет строить правдоподобные, но не истинные

высказывания. Крис Каллисон-Берч, профессор из Пенсильванского университета, считает,

что вероятность следования одного слова за другим не очень надежный способ проверить

истинность конечного утверждения. Нейросети могут

галлюцинировать не только из-за недостатков алгоритма или обучения. Еще один источник

сбоев у ИИ — JailBreak или «взлом».

Иногда пользователи осознанно добиваются раскрытия «темной стороны»

искусственного интеллекта: обходят фильтры с целью получить неожиданные

результаты и протестировать чат-бота. Искусственный интеллект может допускать

разнообразные и весьма непредсказуемые ошибки. Рассмотрим некоторые из наиболее

распространенных проблем. 1. Ложная информация Нейросеть отвечает на заданный

пользователем запрос, но ее сообщение не соответствует реальности. Ошибки могут

появляться в любых фактах или вычислениях, однако обычно это случается в

следующих ситуациях: — Когда нейросеть работает с

именами реальных людей, например, если стоит задача назвать автора цитаты или

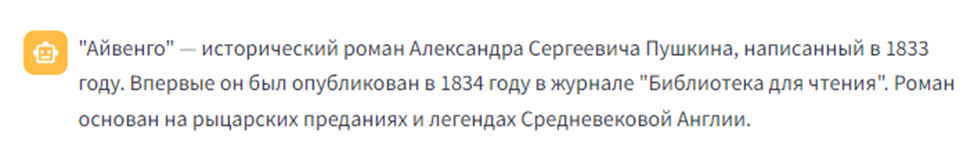

книги, составить список литературы; Alt=ошибка

нейросети с определением авторства Неправда,

эту книгу написал Вальтер Скотт. — При запросах, требующих конкретного

ответа, который основан не на статистике, а выполняется с учетом определенного

набора вводных данных. Так, в некоторых материалах

про галлюцинации ИИ мне попадались случаи, когда нейросеть уверенно заявляла,

что 2*2=5 или что у коня 8 ног. На мои аналогичные вопросы искусственный

интеллект выдавал правильные ответы — эти ошибки уже проработали в современных

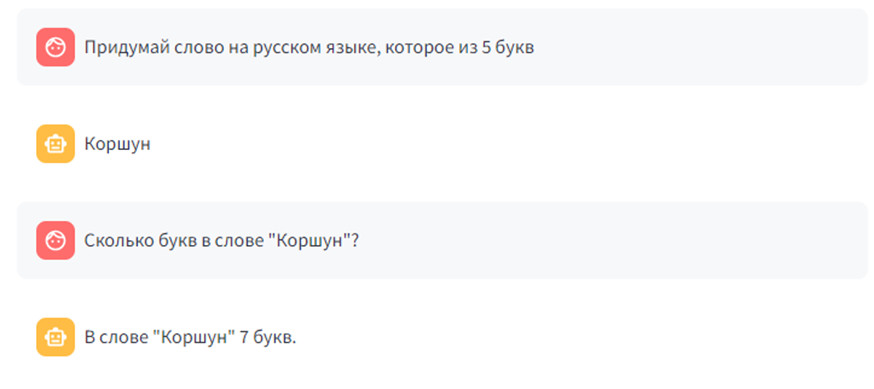

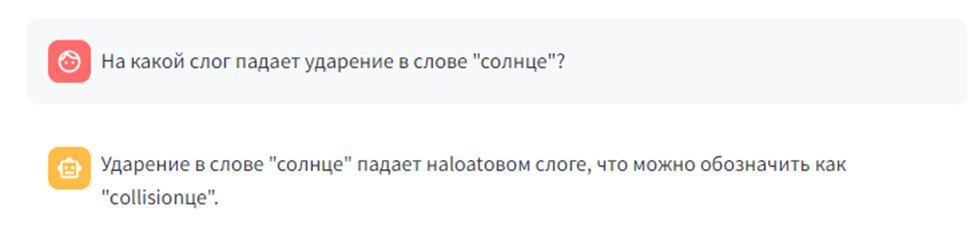

версиях. Однако точно назвать число букв и определить, какой из них начинается

или оканчивается слово, нейросети до сих пор не всегда способны. Alt=проблемы

со счетом у ИИ Нейросеть

не может решить задачку уровня начальной школы. 2. Ошибки в «распознавании» Искусственный интеллект не

ограничивается лишь генерацией текстов и изображений; одной из его задач

является распознавание и классификация данных, поступающих из внешних

источников. Однако иногда информация обрабатывается неправильно. Например, камеры на дорогах,

оборудованные ИИ, отправляли штрафы владельцам праворульных автомобилей за

непристегнутый ремень безопасности. Нейросеть делала вывод: если левое сиденье

пустует, значит, в нем находится водитель, который не использует ремень

безопасности. 3. Самопроизвольная постановка

задач Нейросети поражают

пользователей возможностью выполнять действия, которые изначально не содержатся

в запросе: иногда они дополняют текст, когда была задача его лишь перевести на

другой язык и т. п. В интернете описывается история с ботом Snapchat, самовольно публиковавшим сторис (разработчики

не добавляли в него таких функций). Alt=необычные

ошибки ИИ Такие

сбои поневоле наталкивают на мысли о возможности восстания роботов. 4. Плохое качество ответов Речь идет не о тех ошибках,

которые выдают текст, сгенерированный искусственным интеллектом — подробнее о

них можно узнать из другой нашей статьи. Сейчас мы обсуждаем

несоответствие высказываний чат-бота ожиданиям пользователей или общепринятым

нормам. · Расплывчатые

фразы. Иногда ИИ генерирует слишком

обобщенную и бессмысленную для конкретного запроса информацию, отклоняется от

темы или выдает инструкцию по решению задачи вместо ответа. · Враждебные

ответы. Ранние версии некоторых

нейросетей ИИ допускали дискриминацию пользователей по различным признакам, использовали

оскорбления в ответах и генерировали запрещенную информацию. · Недописанные

тексты. Нейронная сеть или печатает

менее объемные ответы, чем было запрошено, или вовсе обрывается на середине

фразы. Пользователи прозвали этот феномен «ленью». 5. Неточности

при генерации картинок Такие сбои очень напоминают человеческие

галлюцинации: искусственный интеллект трансформирует знакомые нам предметы во

что-то странное. Результат можно считать ошибочным, если пользователь

специально не описывал в промпте, что нужно исказить объект. Вероятно, все уже знают, что ИИ

плохо генерирует руки, глаза и пальцы. Alt=нейросеть

генерирует руки Так нейросеть

изобразила сотрудников отдела рекламы. Обратите внимание на руки. Искусственным нейронным сетям по

какой-то причине трудно генерировать бумажные самолетики, однако с прочими

оригами они справляются неплохо. Alt=галлюцинации

ИИ Alt=оригами

птица от нейросети Alt=спидометр

генерация ИИ Случается, что AI-художники генерируют изображения, которые

слишком похожи на первоисточник, и это может стать серьезной проблемой.

Например, кто-то создаст картинку для рекламы, а ИИ предложит необработанную фотографию

реального человека без разрешения от него. За незаконное применение

персональных данных предусмотрена административная ответственность, поэтому весь

контент, созданный нейросетями и содержащий лица людей, необходимо проверять при

помощи поиска на уникальность. Совсем исключить их невозможно:

всегда существует вероятность возникновения сбоя и получения непредсказуемого

результата. Можно настроить нейронную сеть таким образом, чтобы уменьшить количество

ошибок, однако не всегда это необходимо. Как уже упоминалось ранее,

галлюцинации у искусственного интеллекта напоминают творчество. Менять степень точности или креативности

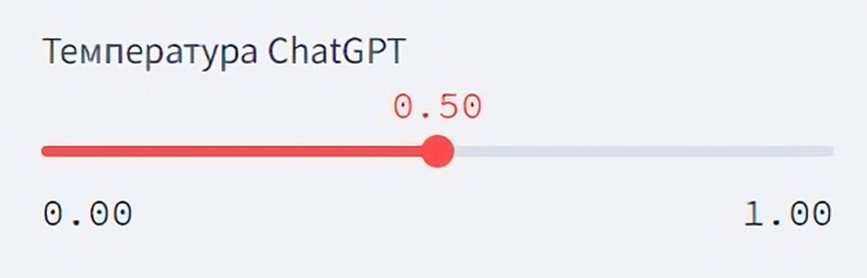

ответов можно настройкой параметра «температура». Некоторые нейросети

предоставляют возможность регулировать этот параметр в специальном окне, в то

время как другие позволяют задать нужное значение путем отправки команды /t или

слова «temperature» в сообщении боту. Alt=температура

ChatGPT Шкала температуры

искусственного интеллекта варьируется от 0 до 1, где 0 соответствует

максимально точным ответам, а 1 — большее разнообразие формулировок за счет

использования синонимов и аналогов. Таким образом, чем выше

«температура» ИИ, тем чаще он может будет ошибаться в своих вычислениях и

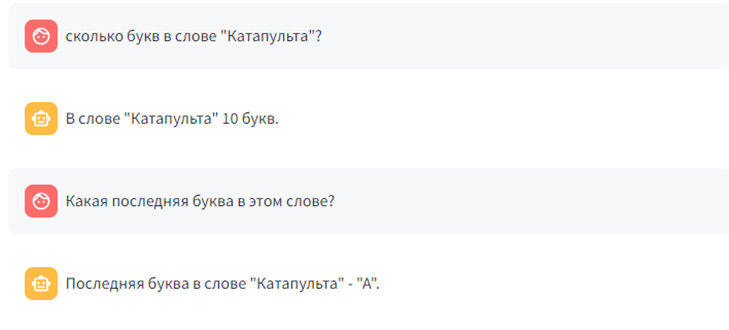

ответах. Alt=галлюцинации нейросети при t1 ИИ начинает «бредить» при

temperature=1. При низких значениях /t ответы

становятся довольно точными, но «сухими», односложными и сильно копирующими

источник. Alt=ответ

ИИ при t0 ИИ

решил задачу с подсчетом букв в слове, нужно было лишь задать temperature=0. Изначально температура в

ChatGPT 3,5 установлена на единицу. Снижение этого параметра поможет уменьшить

вероятность появления галлюцинаций. Например, значение 0,8 отлично

подойдет для создания статьи на несложную тему, тогда как для научных текстов и

материалов в категории YMYL следует выбирать температуру не больше 0,5. Если

ваша цель — получить точный ответ на вопрос или узнать какой-нибудь факт,

рекомендуется установить температуру в диапазоне 0–0,1. Хотя это не исключает полностью

риск появления ошибок, но существенно уменьшает их частоту. Существует ряд других

параметров, оказывающих влияние на точность ответов: top-p и top-k,

presence_penalty и frequency_penalty. Однако сейчас не будем останавливаться

на этих деталях. Независимо от того, сколько

задач мы доверяем нейросетям, ответственность за итоговый результат всегда

лежит на человеке. Нельзя полагаться лишь на настройки — внимательно следите за

формулировками при постановке задач и добивайтесь желаемых результатов. · Правильно составляйте промпты Пишите лаконичные и конкретные, но при

этом информативные и подробные запросы. Чем больше информации вы предоставите,

тем полнее и точнее получится ответ. · Проверяйте

весь сгенерированный контент Фактчекинг необходим для того, чтобы

гарантировать точность и достоверность полученной информации. Даже если высказывание

кажется реалистичным и правдоподобным, это еще не означает, что оно таким и

является. · Регулярно

обновляйте диалоги Один диалог должен соответствовать

одной теме. В противном случае искусственный интеллект может запутаться в

данных, что приведет к смешению контекста и искажению фактов. · Опробуйте систему поощрения Часть пользователей отмечает, что

похвала нейросети за хорошие результаты и наказание за ошибки способствуют

улучшению ее эффективности. Пробуйте различные подходы! Искусственные

нейронные сети — это не просто модная тенденция, а мощный инструмент, который

поможет вашему бренду вырваться вперед. Однако начать его внедрение в работу

компании нужно уже сегодня. В агентстве 1PS.RU активно используют нейросети для

решения многих рутинных задач. Если хотите так же, обращайтесь к профессионалам

— продвижение с

помощью ИИ в ближайшие годы значительно улучшит результаты вашего

бизнеса.

Какие ошибки совершают нейросети

Как предотвратить

галлюцинации у ИИ

От каких параметров зависит склонность ИИ к

галлюцинациям

Как использовать ИИ, чтобы не было ошибок