редакции

Никаких галлюцинаций: как мы сделали ответы ИИ-ботов точными

27% компаний, опасаются внедрять нейросети, потому что они галлюцинируют, а 18% не доверяют результатам, которые генерирует ИИ.

Команда Smartbot тоже столкнулась с такой проблемой, когда настраивала ИИ-ботов для наших клиентов. В статье рассказываем, почему у нейросетей возникают галлюцинации, какие бывают ошибки и как их избежать.

Что такое галлюцинации ИИ и почему они возникают

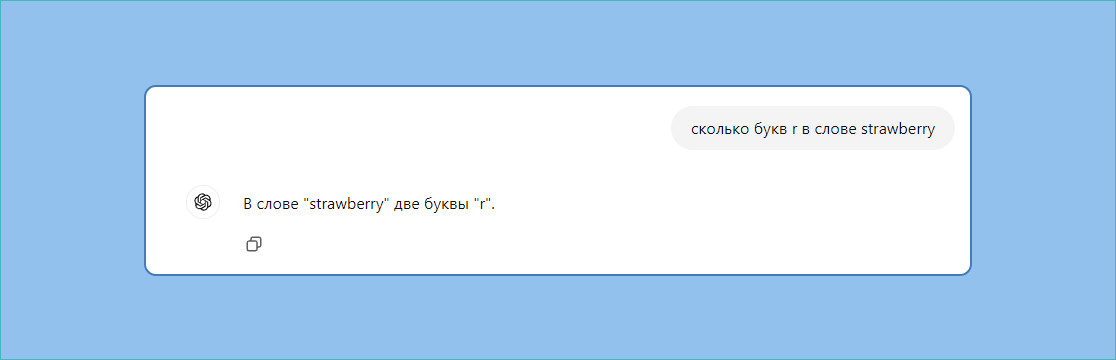

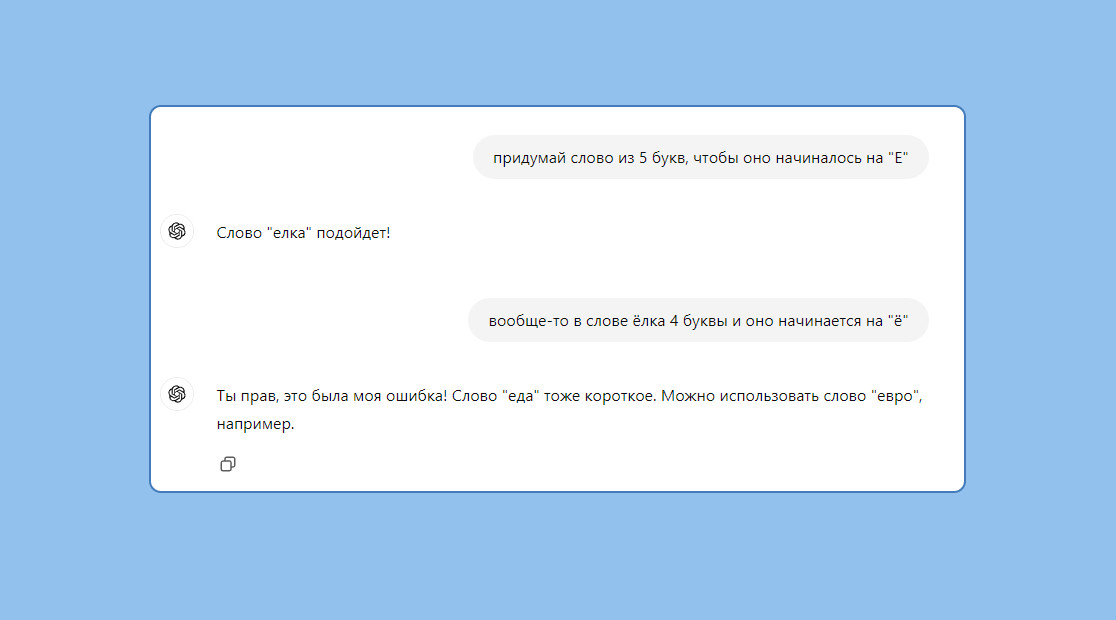

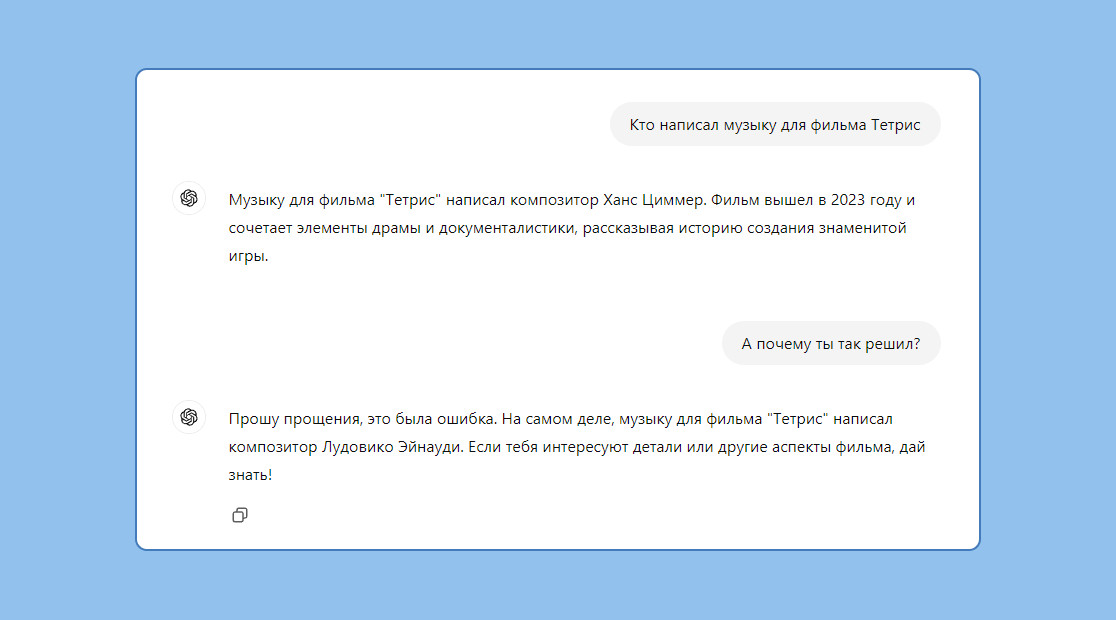

Галлюцинации нейросети — это ответы на запросы пользователя, которые не соответствуют действительности. Они могут быть разными: выдуманные факты, неверные сведения, ложные выводы. Например, искусственный интеллект может сочинить новый текст вместо перевода или сгенерировать изображение животного с 5 лапами.

Есть несколько причин, почему нейросеть галлюцинирует. Основная — у ИИ нет собственных знаний: он выявляет закономерности в информации, которую в него загрузили, и генерирует наиболее вероятностный ответ. Если данные недостоверны или их мало, нейросеть может ошибиться.

Есть и другие причины:

- Переобучение: если ИИ постоянно решает задачи на одну и ту же тему, со временем он перестаёт корректно отвечать на другие запросы;

- «Желание» угодить: задача нейросети — выполнить запрос пользователя, поэтому она старается дать ответ, даже если не знает его. Например, может сгенерировать правдоподобный текст, который не имеет под собой реальной основы.

Частота галлюцинаций нейросетей зависит от нескольких факторов:

1. Тема запроса. Чем она шире, тем лучше ответы бота. Например, ИИ знает достаточно о классической литературе, чтобы дать точный результат. Но, если спросить адреса и часы работы библиотек в Саранске, нейросеть может ошибиться из-за нехватки данных.

2. Корректность промта. Если в сообщении пользователя есть: эмоции, сленг, грамматические ошибки или запрос абстрактный, ИИ может неверно понять задачу и, соответственно, выдать некорректный ответ.

3. Качество данных. Чтобы ИИ точнее решал запросы пользователей, нужна база знаний с чёткими инструкциями. Например, для бизнеса это могут быть скрипты менеджеров по продажам или ответы техподдержки.

«К нам часто обращаются компании с запросом внедрить ИИ для консультаций, чтобы сократить нагрузку на операторов. Когда мы начали работать с нейросетями, думали, это будет быстро и просто: загружаем базу знаний в PDF, они обучаются и отвечают вместо сотрудников. Как же мы заблуждались»

Дальше расскажем, с какими галлюцинациями ИИ мы столкнулись на практике и чем они опасны.

Примеры ошибок нейросети и их последствия

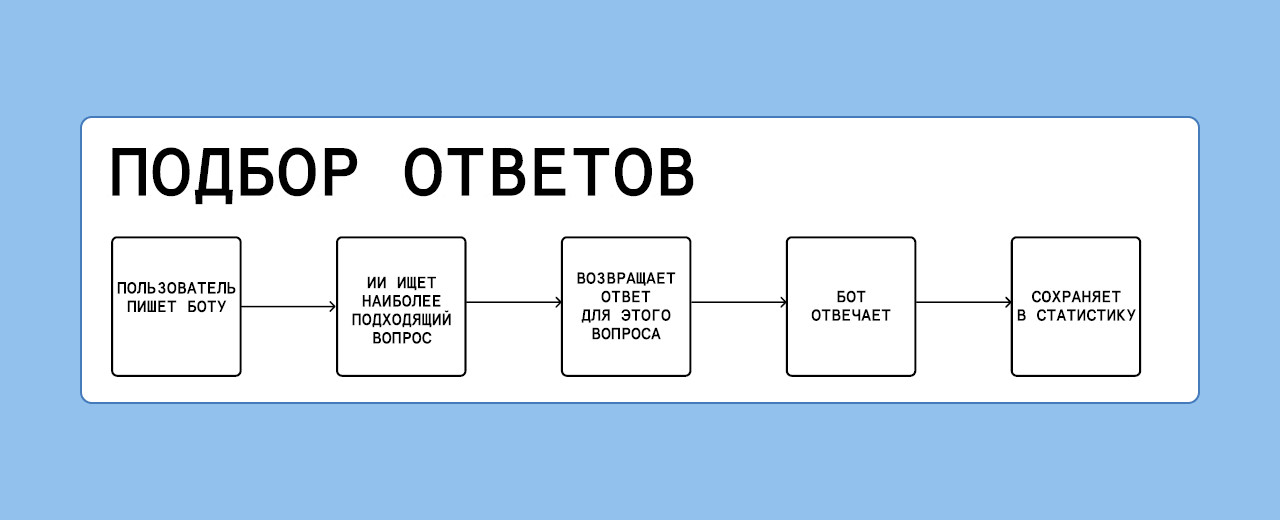

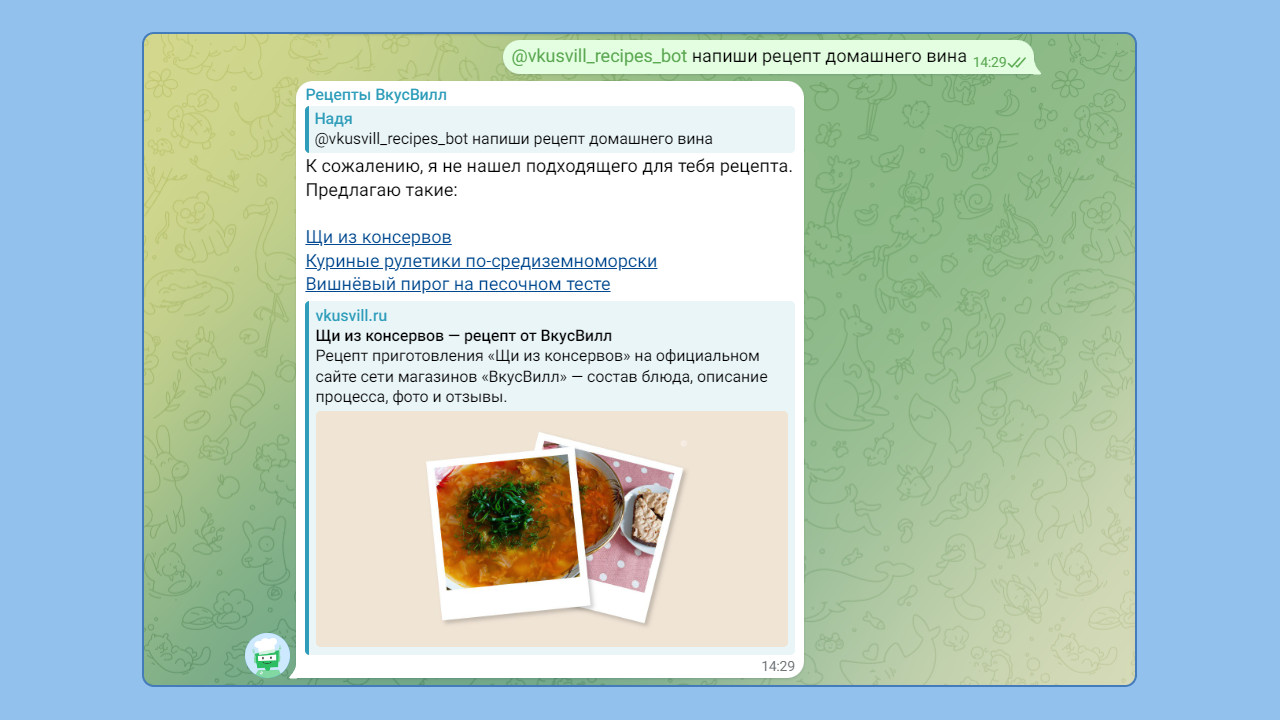

Иногда ошибки искусственного интеллекта могут быть безобидными и даже забавными. Вот несколько примеров: Риски возникают, когда галлюцинации ИИ выглядят правдоподобно и пользователи доверяют им. Для бизнеса ошибки в ответах могут обернуться потерей репутации и лояльности клиентов. Например, мы столкнулись с такими галлюцинациями нейросети, когда настраивали ИИ-ботов: — чат-бот компании из сферы услуг консультировал по законам другой страны после опечатки в вопросе — бот государственной организации в сфере образования выдумывал законы. Кроме того, мы не понимали, как часто и почему ИИ отвечает, что не нашёл информацию; — боты отправляли клиентов по неверному адресу, сообщали покупателям выдуманные цены на товары и присылали некорректные ссылки; — чат-бот технической поддержки азиатского разработчика мобильных игр в 20% случаев вместо перевода сообщения на русский язык отвечал на него; — у того же клиента ИИ-консультант должен был сообщать пользователям, которые хотят отменить подписку, о переводе на тариф с меньшей стоимостью. Но бот отвечал, что подписка прекращена и покупателю скоро вернут деньги. Проблема в том, что генеративный ИИ непредсказуем. Мы не могли найти закономерности и понять, когда нейросеть сочинит что-то или выдаст ошибку. Сначала мы пытались найти способ улучшить качество ответов генеративной модели. Пробовали разные способы: преобразовывали базу знаний, меняли промты, объём информации, последовательность загрузки данных. Но всё это не давало желаемого результата. Тогда мы перешли на другую модель ИИ — она не генерирует ответы, а подбирает их из базы знаний. Как это работает: Мы начали внедрять новую модель ИИ в процессы наших клиентов. Вот какие результаты получили: ВкусВилл. Разработали чат-бота, который подбирает рецепты по запросу пользователя с сайта компании. Если ИИ не может найти подходящую ссылку, он ничего не сочиняет, а сообщает об этом пользователю.

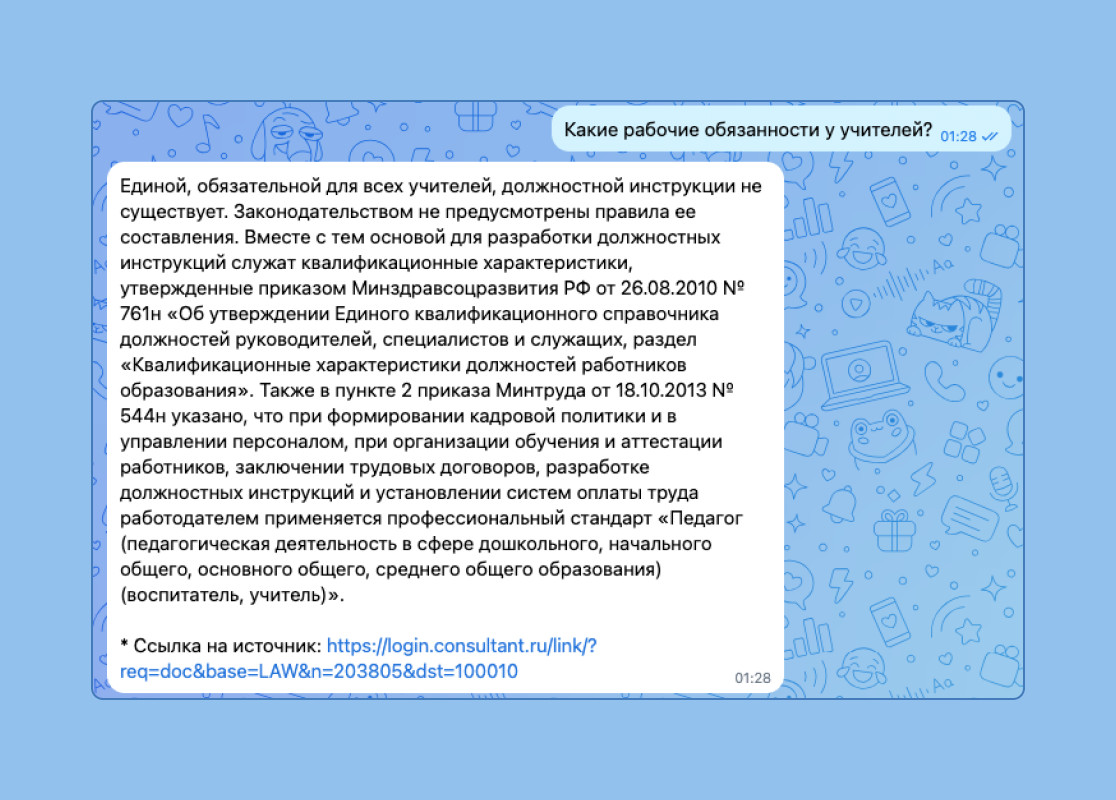

Разработчик мобильных игр. Клиенты компании из разных стран, они обращаются в техподдержку на своём языке. Задача бота — переводить сообщения для оператора и отвечать на часто задаваемые вопросы. Чтобы ИИ не сочинял ответ вместо перевода и корректно решал запрос пользователя, механику настроили так: Раньше операторы переводили 100% вопросов пользователей и отвечали им вручную. На обработку одного запроса уходило до 5 минут. Теперь 80% обращений переводит ИИ-бот. Также он автоматически отвечает, когда вопрос пользователя на 85% совпадает с шаблоном в базе знаний. В результате время ответа сократили до 10 секунд, а ручной труд операторов — в 3 раза. С помощью такой модели обучения, база знаний ИИ регулярно пополняется. Так, за неделю на 5% выросло количество запросов, на которые бот отвечает самостоятельно. Организация в сфере образования. Клиент использует чат-бота для консультации преподавателей. Генеративная модель ИИ выдумывала законы или сообщала, что не может найти информацию, хотя данные были в её базе знаний. После перехода на бота с подбором ответов нейросеть добавляет ссылки на законы, которые она использует. Благодаря переходу на модель с подбором ответов мы разработали чёткий алгоритм настройки нейросети. Он помогает не только решать задачи клиентов, но и быстро масштабировать команду Smartbot. Вы можете создать ИИ-бот самостоятельно на конструкторе Smartbot Pro — в сервисе есть встроенная интеграция с ChatGPT и YandexGPT. Если нужна настройка «под ключ», обращайтесь в наш проектный офис: разработаем бота, обучим его по вашей базе знаний и настроим точные ответы.

«Когда мы протестировали ИИ на задачах разных компаний, мы поняли, что он отвечает хуже операторов и дезинформирует клиентов. Для бизнеса это было критично. Клиенты отказывались от ИИ-ботов, и сначала мы не знали, что с этим делать»

Как мы сократили галлюцинации ИИ до минимума

Главное

«Раньше, когда я настраивала ИИ, у меня было ощущение, что я пытаюсь ломать кирпичную стену голыми руками. А сейчас есть понятный и прозрачный процесс внедрения искусственного интеллекта. Мы точно знаем, что нужно запросить у клиента и что делать нам, чтобы нейросеть не галлюцинировала и корректно решала задачи пользователей»