редакции

Почему защита сайта от парсинга не работает

Почему сайты парсят и зачем нужны системы блокировок

Постоянный мониторинг конкурентного окружения помогает торговым компаниям оптимизировать собственные цены и сформировать востребованный покупателями ассортимент. Наиболее важным фактором при принятии решения о покупке для пользователей является цена, а это значит, что на каждом вашем товаре, цена которого не оптимизирована с учетом конкуренции, вы будете терять потенциальных покупателей. Более того, когда ваши цены постоянно выше цен конкурентов, это вызывает формирование в глазах покупателей образа слишком дорогой компании, что будет крайне сложно исправить.

Более 80% покупателей сегодня проводят самостоятельное сравнение цен на разных площадках перед совершением покупки. Любая компания, которая хочет развиваться в современных условиях, должна организовать постоянный процесс мониторинга актуальных цен и предложений конкурентов, доступных на рынке.

Компании, работающие в реальном мире, отправляют своих сотрудников или аудиторов в магазины конкурентов для сбора актуальных цен на товары. В случае онлайн-продаж необходимо проводить мониторинг сайтов ваших конкурентов. 10 лет назад для мониторинга большинства сайтов интернет-магазинов было достаточно написать специальную программу-парсер, которая бы проходила сайт конкурентов и собирала для вас актуальные цены товаров.

Большое количество таких программ, написанных индивидуально для разных заказчиков, ежедневно заходили на сайты интернет-магазинов и открывали множество страниц с товарами. Так как многие из программ были написаны не профессионалами, они отправляли большое количество запросов к серверам и создавали значительную нагрузку на сайты, замедляя их работу или даже могли привести к недоступности ресурса.

Такое положение дел не устраивало владельцев крупных интернет-магазинов и на рынке стали появляться специальные инструменты для защиты от парсинга — системы защиты от ботов.

Какие системы защиты от ботов есть на рынке

Сегодня на рынке представлено достаточно большое количество решений, которые предлагают клиентам защиту сайта от сбора данных, например Variti, Cloudflare и Stormwall.

Ранее подобные решения блокировали определенные IP-адреса, но с развитием прокси-сервисов подобный метод защиты перестал быть эффективным — адреса закупаются тысячами, а следить и поддерживать актуальный список подозрительных адресов практически невозможно.

Сегодня основная масса решений для защиты сайта от сбора данных анализирует устройства, с которых совершается попытка захода на сайт — проверяется версия браузера, установленные плагины, разрешение экрана и другие настройки компьютера. Таким образом удается отделить реальных покупателей от роботов, которые собирают на сайте информацию.

Подобный метод проверки действительно позволяет защитить сайт от примитивных самописных парсеров, которые зачастую отправляют слишком большое количество запросов. Однако такой способ защиты не способен эффективно препятствовать сбору профессиональными инструментами для мониторинга.

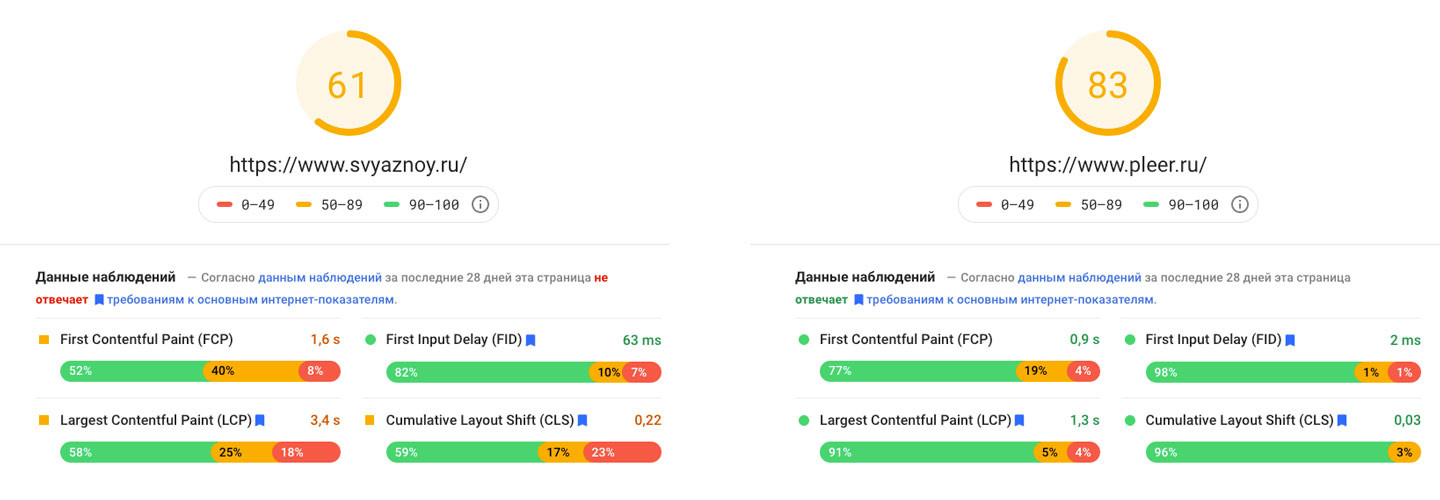

Стоит отметить, что подключение системы защиты сайта от ботов замедляет взаимодействие клиента и сервера, что приводит к медленной загрузке страниц и оттоку пользователей. Приводим для сравнения показатели загрузки сайта с защитой — «Связной», и сайта без защиты — Pleer.ru Профессиональные решения для мониторинга информации на сайтах подходят к процессу сбора данных ответственно, стараясь максимально сократить количество запросов к сайтам для сбора данных и не допускать повышенных нагрузок на сервера собираемых сайтов, чтобы предотвратить их перегрузку. При попытках проверки сайтом запроса пользователя система сбора данных начинает себя вести как полноценный браузер типового пользователя, отправляя идентичные запросы к сайту, как если бы это делал реальный посетитель сайта, вплоть до эмуляции движения мыши. Это делает робота-сборщика неотличимым от обычного покупателя, а блокировать

контент для реальных пользователей не станет ни один магазин. Таким образом даже самые технологичные системы блокировок не могут полноценно определять и препятствовать работе программ для сбора данных. Несмотря на низкую эффективность решений для блокировок контента при сборе данных современными технологичными инструментами, есть ряд случаев, в которых такие решения могут быть полезны для сайтов. Сегодня на рынке все еще широко распространены «самописные парсеры», которые не обладают такими же возможностями по обходу блокировок и могут

быть определены и заблокированы. Разработку таких дешевых парсеров часто заказывают у фрилансеров для экономии средств на мониторинг, однако после первых изменений на сайте такой парсер теряет актуальность и

нуждается в обновлении. Кроме того, разработчики подобных решений крайне редко уделяют внимание минимизации нагрузок на сервера сайтов. Такие решения могут делать слишком много однотипных запросов, что будет выглядеть подозрительно для сайта. За счет этих факторов самописные парсеры наиболее легко распознаются и успешно блокируются. Владельцу интернет-магазина важно различать защиту сайта от сбора данных и защиту от DDoS-атак — это разные инструменты, функционал которых может пересекаться, но в целом они решают различные задачи. При выборе любого инструмента нужно четко понимать, для каких задач он будет

эффективен, а для каких нет. Подключение к сайту системы защиты от сбора данных может дать ложное чувство безопасности, но если у вас успешный магазин, то основные конкуренты в любом случае будут собирать ваши цены и принимать решения на основе данных. Бюджеты на такие решения выгоднее направить на анализ ваших конкурентов, чем на защиту данных. Сегодня невозможно полностью исключить или даже ограничить сбор ваших

данных другими игроками на рынке, поэтому в условиях высокой конкуренции важно проактивно изучать рынок, принимать решения на основе четкого понимания ситуации и действовать на опережение, а не прятать голову в песок в надежде, что ваши цены останутся в секрете.

Каким образом происходит обход блокировок

Какие задачи можно решить с помощью защиты от парсинга

Почему системы защиты от парсинга не смогут защитить ваши цены