редакции

Парсинг бесплатно: 30 программ, сервисов и фреймворков

Парсинг — это автоматизированный сбор данных в интернете. Применяется для сбора информации о ценах конкурентов, файлов, SEO данных, описаний товаров, контактов, пользовательских рейтингах и отзывов, для других задач, когда нужно получить значительный объем информации, который невозможно собрать руками или ручная обработка будет слишком трудозатратна. При этом, часто у начинающих компаний нет лишних средств на подобные инструменты и решением проблемы может стать самостоятельное изучение инструментов для парсинга, которые можно использовать бесплатно.

Для начала, посмотрим, какие бывают инструменты для парсинга, условно разделим на две части. Первая — это разработка программы парсера. Такие программы пишут программисты, на различных языках программирования — Python, Java, JavaScript. Подход позволяет создать любую логику скрипта и в конечном итоге гарантированно решит задачу, но требует времени и средств на создание и поддержание парсера.

Вторая — обычные пользователи, которым приходится выбирать из множества готовых решений, в которых реализован набор возможностей, с одной стороны такой подход быстр и практичен, но если возможностей сервиса вам не хватит, то придется искать другое решение, это приводит к трате времени на изучение нескольких инструментов без гарантии, что вы в конечном итоге решите задачу.

Программы для парсинга

Десктоп программы подойдут, если вам нужно не сложное решение с возможностью быстрого старта и не требующее знаний программирования. Возможности и специализация программ отличаются, а так же ограничены мощностью вашего компьютера, в целом программы для парсинга — отличное решение для простых задач.

1. Screaming Frog SEO Spider

Screaming Frog SEO Spider — известная программа, специализирующаяся на работе с SEO данными, имеет широчайший функционал

для аудита сайтов и парсинга данных, перечисление всех возможностей программы

займет много времени, в нашем обзоре рассмотрим основные возможности программы.

При первом взгляде интерфейс программы кажется, но через некоторое время понимаешь,

что интерфейс структурирован, вкладки организованны для быстрого доступа к важной

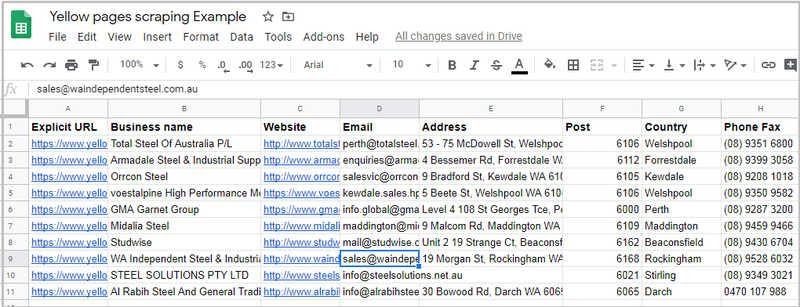

информации и в целом работа удобна. Ограничения в бесплатной версии: Программа имеет хорошую документацию, много обучающих уроков, на нее написано много обзоров, освоить программу при желании будет не сложно. Полная версия программы позволит парсить не только SEO информацию, но и любую нужную вам, с помощью язык запросов XPath. Возможности программы: Доступные ОС: Easy Web Extract позволяет собирать данные с простых html сайтов и сайтов с динамически подгружаемым содержимым. Для использования программы не нужны знания программирования, работа ведется через мастер, который пошагово поможет организовать настройку шаблона для парсинга. Для того, чтобы быстро освоить программа предлагает базу знаний и видео уроки. Особенность — вы можете задать автоматический поиск нужных вам товаров на стадии настройки и собирать только нужные данные. Другая особенность Easy Web Extract — возможность многопоточного сбора, это позволит экономить время выполнения парсинга, но будте аккуратны при многопоточном сканировании, целевой сайт может блокировать ваш ip из-за подозрительной активности. В Easy Web Extract есть возможность парсинга динамически загружаемых данных, при тестировании программа справилась не со всеми сайтами, проверьте эту возможность на нужном вам сайте. Ограничения в бесплатной версии: Таким образом, не смотря на все возможности в бесплатной версии программа подойдет для парсинга небольшого объема информации, если это ваш вариант, то она станет отличным выбором. Возможности: Доступные ОС: FMiner — программа для парсинга сайтов, с визуальной настройкой, не требует знания языков программирования, она записывает ваши действия создавая таким образом сценарии, которые вы можете редактировать, сохранять и воспроизводить в последующем. Программа понимает динамически загружаемые данные, например AJAX, поддерживает многопоточность, предоставляет возможность работать с результатами поиска и экспортирует данные в несколько выходных форматов. Для быстрого старта есть видео-уроки и мануалы, есть раздел с документацией, рассказывающий в краткой форме возможности и основы работы с программой. Ограничения в бесплатной версии: Возможности: Доступные ОС: Helium scraper — программа для парсинга данных с сайтов. Принцип работы с программой похож на работу с рассмотренной выше программой, с отличием — вместо визуального представления действий программа показывает код. Интерфейс у программы не самый дружелюбный для неподготовленного пользователя, но программа имеет базу знаний и видео-уроки, которые помогут освоить принципы работы. Функциональность программы имеет ряд особенностей по отношению к рассмотренным выше. Одна из ключевых — это возможность собирать большие базы данных, до 140 Терабайт, если ваша задача подразумевает сбор большого объема информации, то стоит обратить внимание на Helium scraper. Так же программа может работать через API, вы можете интегрировать запросы к целевым сайтам в свой проект. Ограничения в бесплатной версии: Возможности: Доступные ОС: WebHarvy — интересный вариант для парсинга сайтов, программа предлагает простой и наглядный интерфейс для захвата данных и в этом ее главная особенность — она интуитивно понятна с первого взгляда. WebHarvy не подойдет для каталогов со сложной структурой вложенности, программу нужно выбирать для сайтов с простой структурой вложенности не далее второго уровня, приятный бонус, программа понимает динамически загружаемые данные, так же вы сможете подключить свои прокси и пройти по заранее подготовленному списку адресов. Программа позволяет пользоваться регулярными выражениями, например вы сможете очистить html код. Ограничения в бесплатной версии: Из-за ограничения в 2 страницы, программа сильно ограничивает парсинг каталогов, но если есть возможность вывести данные на одну страницу, WebHarvy — хороший выбор. Возможности: Доступные ОС: Screen-Scraper — еще одно программное решение для сбора данных с сайтов. Программу сложно назвать простой, потребуется время для обучения, но возможности бесплатной версии высоки. Screen-Scraper может собирать данные, переходить по ссылкам, заполнять и отправлять формы, переходить на страницы результатов поиска и скачивать различные файлы. Программа может справится с практически любым сайтом, в том числе с AJAX данными. Ограничения в бесплатной версии: Возможности: Доступные ОС: Облачные сервисы, в отличие от программ позволяют собирать не использую ресурсы вашего компьютера, такие сервисы программируются через окно браузера или программу на вашем компьютере, а вот сам процесс извлечения данных выполняется на стороннем сервере. Сервисы как и программы предоставляют возможности осуществлять парсинг бесплатно. Octoparse — популярный сервис для парсинга, позволяет визуально, те без написания кода программировать парсер. Преимущество сервиса для неподготовленного пользователя — множество статей, объясняющих как им пользоваться. В плане функциональности сервис предоставляет хорошие лимиты в бесплатной версии. Ограничения в бесплатной версии: Возможности сервиса: Mozenda — известный и один из старейших облачных сервисов. Предлагает настройку визуальным захватом данных, язык XPath для настройки извлечения сложных данных, разработчикам сервис предлагает создание сценариев парсинга. Сервис предлагает демонстрационный период на целый месяц, настройка парсинга происходит через приложение, которое нужно установить на компьютер, сбор информации происходит в облаке. Ограничения в бесплатной версии: Возможности сервиса: Diffbot — инновационный сервис использующий машинное обучение и компьютерное зрение для парсинга данных. Сервис способен автоматически определить тип страницы, на которой находится и собирать различные данные данные для поддерживаемых типов страниц. Заявляется о поддержке статей, карточек товаров, изображений, обсуждений и видео. Ограничения в бесплатной версии: Возможности сервиса: Scraper api — сервис требующий программирования, работает через безголовый браузер. Сильная сторона Scraper API — смена Ip адреса для каждого запроса, сервис выбирает прокси из миллиона доступных и автоматически повторяет неудачные запросы, до тех пор, пока не соберет нужные данные. Сервис умеет работать с капчей. Ограничения в бесплатной версии: Сервис может работать с одним из языков программирования — NodeJS, Python, Ruby или PHP. Возможности сервиса: Scrapy Cloud — облачная платформа позволяющая программировать парсеры, требует знания языков программирования. Предоставляет гибкие инструменты для создания проектов с любой нужной вам логикой. Сервис предлагает безлимитное количество данных на бесплатном тарифе, но ограничивает время работы одним часом. Ограничения в бесплатной версии: Возможности сервиса: ScrapingBee — сервис для парсинга данных требующий программирования, сбор данных осуществляется через безголовый браузер. Особенность ScrapingBee — рендеринг Javascript, это позволяет парсить любой сайт, использующий React, Angulars, Vue.js и другие библиотеки. Сервис использует прокси сервера для снижения вероятности блокировки, так же это позволит запустить парсинг в несколько потоков, что увеличит скорость сбора данных. Ограничения в бесплатной версии: Сервис требует знания программирования на одном из языков — CURL, Python, NodeJS, Java, Ruby, Php, Go. Возможности сервиса: Apify — сервис основанный на готовых решениях. Магазин Apify позволяет использовать заранее подготовленные шаблоны для самых популярных пользовательских запросов: сбор данных с Amazon, Instagram, Booking и т.д. Сервис дает доступ к API через подключение к которому и происходит сбор данных, все представленные шаблоны хорошо описаны, так же вы можете изменить настроенный шаблон, чтобы внести нужные вам изменения. Ограничения в бесплатной версии: Возможности сервиса: Web Scraper — сервис для парсинга созданный, чтобы упростить парсинг данных с сайтов. Парсер настраивается в визуальном редакторе, вы просто указываете какие элементы хотите захватить. Web Scraper позволяет создавать карты сайта из различных типов селекторов. Эта система позволяет в последующем адаптировать извлечение данных к разным структурам сайта. Ограничения в бесплатной версии: Возможности сервиса: CrawlMonster — SEO ориентированный инструмент для парсинга. С помощью сервиса вы сможете получить доступ к SEO данным вашего веб-сайта, таким как — контент, статусы страниц, код сайта, различные ошибки, сервис оповестит о проблеме с безопасностью и многое другое. Ограничения в бесплатной версии: Возможности сервиса: eScraper — сервис который подойдет для парсинга сайтов электронной коммерции у сервиса есть настроенные интеграции с магазинами построенными на Magento, PrestaShop, WooCommerce или Shopify. Может парсить динамически загружаемый контент, такой как, раскрывающиеся списки, разделы «показать еще» и «следующая страница» и чекбоксы. Ограничения в бесплатной версии: Возможности сервиса: 80legs — сервис для парсинга сайтов использующий заранее созданные шаблоны. Шаблоны для парсинга от 80legs используют технологии Javascript, которые вы можете менять в соответствии с вашими задачами. В шаблонах можно настроить, какие данные будут собираться и по каким ссылкам нужно переходить. Ограничения в бесплатной версии: Возможности сервиса: Phantom Buster — еще один облачный сервис, предлагающий готовые шаблоны. Сервис специализируется на социальных сетях, таких как Facebook, Twitter, Instagram, LinkedIn и т.д. Парсинг не требует умения программировать, вы сможете легко выполнять привычные для социальных сетей действия автоматически, такие как отслеживание активности профилей, авто-лайки постов, отправка сообщений и прием заявок. Ограничения в бесплатной версии: Возможности сервиса: Webhose — этот сервис специализируется на новостях, блогах, форумах и работе с даркнетом. Webhose работает через API, который предоставляет доступ к данным в режиме реального времени. Также сервис откроет доступ к огромной базе исторических данных. Ограничения в бесплатной версии: Сервис подойдет, если вам нужно достать информацию из новостных источников или даркнета. Также, если есть необходимость в исторических данных. Возможности сервиса: Parsers — сервис парсингас визуальной настройкой парсинга, работает через расширение для браузера. Сервис упрощает настройку сбора данных при помощи алгоритмов машинного обучения, вам нужно выбрать данные только на одной, первой странице сайта, далее сервис ищет похожие страницы на сайте и извлекает указанные данные. Ограничения в бесплатной версии: Возможности сервиса: Agenty — сервис предлагающий настройку парсера через расширение для браузера Chrome. Сервис очень прост в настройке, нужно просто кликнуть на данные которые вы хотите собрать, работает при помощи CSS-селекторов, экспортирует данные в JSON, CSV, TSV. Ограничения в бесплатной версии: Возможности сервиса: Grepsr — расширение для браузера Chrome с визуальной настройкой парсеа. Сервис предлагает интуитивно понятный интерфейс, API для автоматизации сбора данных и интеграции с популярными облачными дисками — Dropbox, Google Drive, Amazon S3, Box, FTP. Ограничения в бесплатной версии: Возможности сервиса: Web Robots — облачный сервис использующий для настройки расширение для браузера Chrome. Работа с сервисом максимально упрощена, это один из самых простых сервисов, парсер настраивается визуально, разобраться с ним не составит труда, просто указываете нужные данные на странице и сервис автоматизирует дальнейший действия. Функциональность сервиса так же проста, парсер подойдет для простейших задач. Ограничения в бесплатной версии: Возможности сервиса: Data miner — еще один сервис, использующий шаблоны и работающий через расширение для браузера, поддерживаются Google Chrome и Microsoft Edge. Имеет визуальный интерфейс для настройки данных. Data Miner предлагает просто гигантское количество настроенных шаблонов, более 40 000 для самых популярных сайтов. При помощи готовых шаблонов, вы сможете собрать данные в несколько кликов мышкой. Сервис позволяет работать с нужным вам списком адресов. Ограничения в бесплатной версии: Возможности сервиса: Scraper.AI — сервис работающий через расширение для браузера. Поддерживаются Chrome, Firefox и Edge. Scraper.AI не требует работы с кодом и предлагает простую настройку через визуальный интерфейс. Так же вы можете использовать готовые шаблоны для соцсетей — Facebook, Instagram и Twitter. Ограничения в бесплатной версии: Возможности сервиса: Фреймворки — инструментарий для разработки собственных парсеров, для работы с ними необходимо знать один из языков программирования, эти инструменты помогут реализовать проект любой сложности. Можно написать нужную вам логику парсинга, парсить любые сайты, конечно, это потребует программистов, выделенных серверов и покупки прокси. Scrapy — фреймворк для парсинга с открытым исходным кодом. Scrapy использует язык программирования Python и является одним из самых популярных фрейморков для парсинга. Одно из главных достоинств Scrapy — возможность асинхронной обработки запросов. Это позволяет не ждать, пока запрос будет завершен, парсер может отправлять параллельные запросы или выполнять другую логику в это время. Если в процессе вызова произойдет ошибка, парсер не прекратит свою работу, параллельные процессы продолжат выполняться. Такой подход позволяет работать очень быстро и получать высокую отказоустойчивость запрсов. Scrapy также предлагает управление и другими параметрами парсинга, вы сможете задавать задержку между каждым запросом или группой запросов, ограничить количество одновременных запросов для каждого домена или IP адреса или даже использовать автоматический расчет нужной задержки между запросами. В силу популярности у Scrapy большое комьюнити и написана подробная документация. BeautifulSoup — фреймворк, также использующий популярный язык программирования Python, позволяет парсить данные из HTML и XML документов. Фреймворк предлагает подробную документацию, для открытия ссылок и сохранения результатов потребуется подключить сторонние библиотеки. Он более прост функционально по сравнению со Scrapy, BeautifulSoup стоит выбрать, если задачи парсинга не требуют распределения данных, не требуют реализации сложной логики и не нужно применять прокси сервера. Но, в противовес меньшему функционалу BeautifulSoup более прост в освоении, библиотека подойдет начинающим программистам, множество мануалов помогут быстро разобраться в продукте. Jaunt —библиотека для парсинга на языке Java с открытым исходным кодом. Работает через легкий и быстрый безголовый браузер (без графического интерфейса). Браузер дает доступ к DOM и контроль над каждым HTTP запросом — ответом. Jaunt позволяет скриптам на Java: Selenium — это настоящий «швейцарский нож» для парсинга, представляет из себя набор инструментов для автоматизации браузеров, включает инструменты для управления, развертывания, записи и воспроизведения действий. Все продукты Selenium выпущены с открытым исходным кодом. Парсеры можно писать на различных языках — Python, Java, C#, JavaScript или Ruby. Selenium позволяет связывать не только браузеры, но и сервера для решения сложных задач. Этот инструмент стоит выбрать, если перед вами стоят большие задачи и есть ресурсы для их реализации. Grab — фреймворк позволяющий писать скрипты для парсинга на языке Python. С помощью Grab можно создавать парсеры различной сложности, как простые скрипты на 5 строчек, так и сложные асинхронные поисковые алгоритмы, способные обрабатывать миллионы страниц. Фреймворк имеет API для выполнения запросов и последующей обработки данных, например, для взаимодействия с деревом DOM HTML- документа. Фреймворк Grab состоит из двух частей: В заключении расскажу о сервисе парсинга, развитием которого я занимаюсь — iDatica. Мы делаем разработку парсеров и сопровждающих услуг: очищаем данные, сопоставляем (матчим) товары, визуализируем информацию в Bi сервисах, делаем это качественно, под ключ. Почему наши услуги нужны, если есть бесплатные инструменты? Мы работаем с масштабными задачами, добывая каждый день миллионы значений. Для таких задач требуются специалисты, сервера, прокси, системы обхода капч, постобработка, и многое другое. Если говорить более развернуто — мы поможем, когда продукт, не может собрать данные с нужного сайта, например, большинство даже платных версий сервисов из списка, при тестировании не справились с парсингом Яндекс.Маркет, а тем или иным способом защищаются от парсинга многие коммерческие сайты. Мы напишем логику парсинга под ваши требования, например, сначала найти на сайте нужную информацию, выбрать категории, бренды, парсинг набора ссылок или парсинг сайта с нестандартной структурой. Мы сравним ваши товары и товары конкурентов с максимальной точностью, в противовес — автоматические алгоритмы сравнения товаров часто не отрабатывают на 100% и требуют ручной доработки с вашей стороны, а часть сервисов потребует предварительно сопоставить ваши товары и товары конкурентов, а если какие-то адреса карточек изменяться, делать это придется заново. Все это выливается в оплату сервиса, оплату труда сотрудника, который работает с сервисом, а если сервис в конечном итоге не справится, в потраченное время и необходимость искать новый сервис. Выбирая работу с нами, вы просто будете получать нужный результат в готовом виде.

2. Easy Web Extract

3. FMiner

4. Helium scraper

5. WebHarvy

6. Screen-Scraper

Облачные сервисы для парсинга

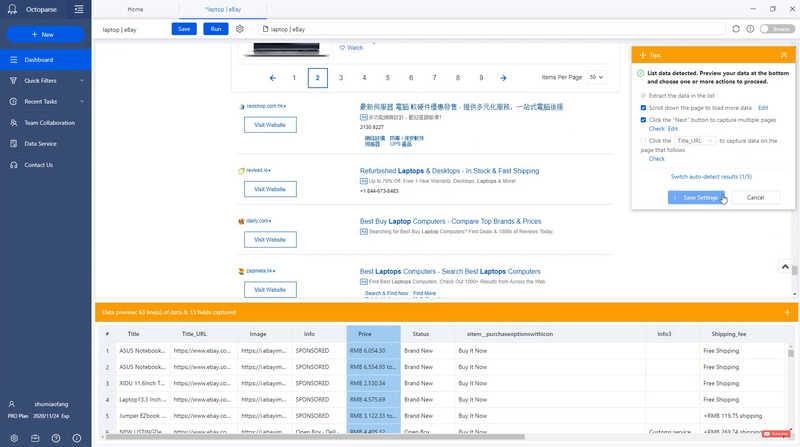

7. Octoparse

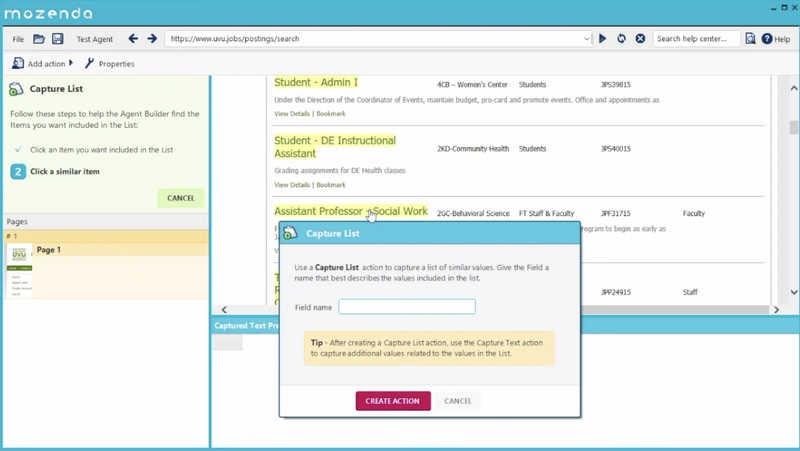

8. Mozenda

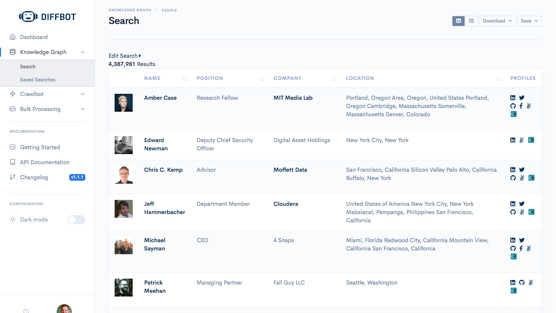

9. Diffbot

10. Scraper api

11. Scrapy Cloud от Scrapinghub

12. ScrapingBee

13. Apify

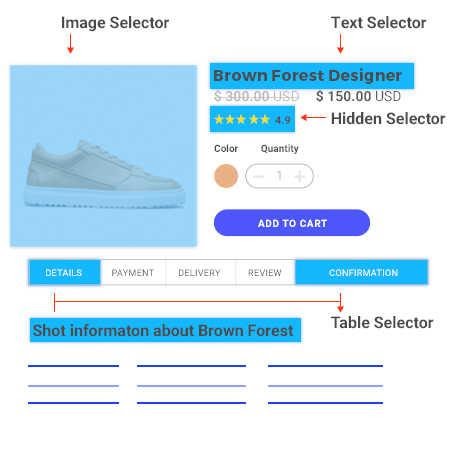

14. Web Scraper

15. CrawlMonster

16. eScraper

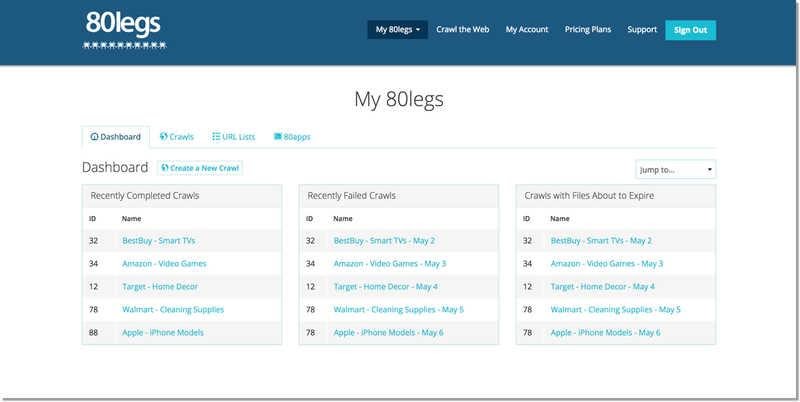

17. 80legs

18. Phantom Buster

19. Webhose

20. Parsers

21. Agenty

22. Grepsr

23. Web Robots

24. Data miner

25. Scraper.AI

Бесплатные фреймворки (библиотеки) для парсинга

26. Scrapy

27. BeautifulSoup

28. Jaunt

29. Selenium

30. Grab

Платный сервис в заключении